وبلاگ

تمامی مقالات ما

ساخت کمپین تبلیغاتی دیجیتال از صفر تا صد

در دنیای بازاریابی امروز، ساخت کمپین تبلیغاتی دیجیتال یکی از مهمترین ابزارها برای رشد برند و افزایش فروش است. یک کمپین دیجیتال موفق تنها با نمایش آگهی در فضای آنلاین شکل نمیگیرد، بلکه نیازمند طراحی کمپین هدفمند، برنامهریزی دقیق و اجرای اصولی است. در این راهنما از گنج دیجیتال، مسیر اجرای کمپین دیجیتال را از گام نخست تا ارزیابی نهایی بررسی میکنیم تا با رعایت اصول و بهرهگیری از ابزارهای کاربردی، بتوانید کمپینی کارآمد و نتیجهبخش بسازید. کمپین تبلیغاتی دیجیتال چیست و چرا مهم است؟ کمپین تبلیغاتی دیجیتال مجموعهای از فعالیتهای هدفمند بازاریابی آنلاین است که با استفاده از کانالها و ابزارهای دیجیتال برای دستیابی به اهداف مشخص انجام میشود. این کمپین میتواند شامل نمایش تبلیغات در شبکههای اجتماعی، موتورهای جستجو، وبسایتها، اپلیکیشنها و سایر پلتفرمهای آنلاین باشد. در یک کمپین دیجیتال، برخلاف تبلیغات سنتی که بیشتر بر رسانههای آفلاین مانند تلویزیون، رادیو یا بیلبورد تکیه دارد، امکان هدفگذاری تبلیغاتی دقیق فراهم است. علاوه بر این، اجرای کمپین دیجیتال امکان سنجش و تحلیل عملکرد در لحظه را فراهم میکند. با استفاده از دادهها و شاخصهای کلیدی عملکرد (KPI)، میتوان اثربخشی تبلیغ را ارزیابی و در صورت نیاز، به سرعت اصلاحات لازم را اعمال کرد. این انعطافپذیری، کمپین تبلیغاتی دیجیتال را به یکی از ابزارهای کلیدی بازاریابی مدرن تبدیل کرده است. کاربرد کمپین تبلیغاتی دیجیتال برای کسبوکارها کمپین تبلیغاتی دیجیتال با بهرهگیری از ابزارهای آنلاین، اهداف متنوعی را برای کسبوکارها پوشش میدهد. مهمترین کاربردهای آن عبارتند از: افزایش آگاهی از برند یکی از مهمترین اهداف کمپینهای دیجیتال، معرفی برند به مخاطبان جدید و تثبیت نام آن در ذهن مشتریان است. با طراحی کمپینهدفمند، میتوان پیام برند را در مقیاس وسیع و با هزینه بهینه منتشر کرد. جذب مشتریان بالقوه از طریق هدفگذاری تبلیغاتی، میتوان افرادی را که بیشترین احتمال خرید را دارند شناسایی و جذب کرد. این کار باعث میشود نرخ تبدیل افزایش یابد و منابع بهدرستی مصرف شوند. افزایش فروش و درآمد با استفاده از روشهایی مثل تبلیغات کلیکی و تبلیغات شبکههای اجتماعی، امکان هدایت سریع مخاطب به صفحه خرید و افزایش مستقیم فروش فراهم میشود. ایجاد تعامل با مشتریان اجرای کمپین دیجیتال میتواند به شکل نظرسنجی، مسابقه یا تولید محتوای تعاملی باشد که مشارکت کاربران را افزایش دهد و وفاداری آنها به برند را تقویت کند. تحلیل و بهینهسازی بازاریابی کمپینهای دیجیتال با قابلیت سنجش عملکرد، امکان بررسی رفتار مشتریان و بهبود مداوم استراتژی را فراهم میکنند. این ویژگی، مزیت بزرگی نسبت به تبلیغات سنتی محسوب میشود. مقایسه کمپین تبلیغاتی دیجیتال و سنتی برای درک بهتر ارزش کمپین تبلیغاتی دیجیتال، لازم است آن را با تبلیغات سنتی مقایسه کنیم. هر دو روش هدف جذب مشتری و افزایش فروش را دنبال میکنند، اما تفاوتهای مهمی در اجرا، اندازهگیری و بازدهی دارند. معیار مقایسه کمپین تبلیغاتی دیجیتال کمپین تبلیغاتی سنتی هزینه انعطافپذیر و قابل کنترل بر اساس بودجهبندی تبلیغ معمولاً هزینه بالا و ثابت هدفگذاری تبلیغاتی دقیق بر اساس سن، جنسیت، موقعیت جغرافیایی، علایق و رفتار کاربران محدود به منطقه و گروه کلی مخاطبان اندازهگیری و تحلیل امکان سنجش لحظهای عملکرد و اصلاح سریع تحلیل پس از اتمام کمپین و معمولاً با دادههای محدود انعطاف در تغییرات تغییر پیام، طراحی یا بودجه در طول اجرای کمپین تغییرات دشوار و پرهزینه کانالهای تبلیغاتی متنوع شامل شبکههای اجتماعی، موتورهای جستجو، ایمیل، وبسایتها رسانههای سنتی مانند تلویزیون، رادیو، بیلبورد و چاپی بازدهی سرمایه قابل ارزیابی دقیق و بهینهسازی مداوم ارزیابی تقریبی و کمدقت در مجموع، اجرای کمپین دیجیتال به دلیل انعطاف، دقت در هدفگذاری تبلیغاتی و امکان طراحی کمپین متناسب با شرایط بازار، گزینهای مؤثرتر برای بسیاری از کسبوکارها است. مراحل طراحی کمپین تبلیغاتی دیجیتال طراحی کمپین مهمترین نقطه شروع در ساخت کمپین تبلیغاتی دیجیتال است. هرچه این مرحله دقیقتر و علمیتر انجام شود، شانس موفقیت در اجرای کمپین دیجیتال بالاتر خواهد رفت. در این بخش، مسیر گامبهگام طراحی یک کمپین مؤثر را بررسی میکنیم. ۱. تعیین هدف کمپین پایه هر کمپین تبلیغاتی دیجیتال مشخصکردن اهداف آن است. بدون داشتن هدف روشن، امکان ارزیابی عملکرد و بازدهی وجود ندارد. این اهداف میتواند شامل افزایش آگاهی از برند، جذب مشتریان بالقوه، فروش مستقیم محصول یا خدمات، یا حتی بهبود تعامل کاربران باشد. در طراحی کمپین باید اهداف SMART (مشخص، قابلاندازهگیری، دستیافتنی، مرتبط و زمانبندیشده) تعریف شود. مثلاً به جای گفتن (میخواهیم فروش بیشتر شود)، هدف باید به شکل (افزایش ۲۰ درصدی فروش آنلاین طی ۳ ماه) مشخص شود. چنین رویکردی در هدفگذاری تبلیغاتی باعث میشود بودجه و کانالها بهینه انتخاب شوند. ۲. شناخت و تحلیل مخاطبان هدف هیچ کمپین دیجیتال موفقی بدون شناخت عمیق از مخاطب شکل نمیگیرد. این مرحله شامل استفاده کردن از ابزارهای تحلیلی و دادههای فروش برای ترسیم کردن پرسونای مشتریهاست. این پرسونا شامل ویژگیهایی مثل سن، جنسیت، شغل، علایق، موقعیت جغرافیایی و حتی رفتار خرید آنلاین است. با این اطلاعات میتوانید هدفگذاری تبلیغاتی دقیقی انجام دهید تا پیام کمپین به افرادی برسد که بیشترین احتمال تعامل یا خرید را دارند. این کار نه تنها باعث کاهش هزینهها میشود، بلکه اثربخشی بودجهبندی تبلیغ را نیز افزایش میدهد. ۳. انتخاب کانالهای مناسب انتخاب بسترهای تبلیغاتی در طراحی کمپین بر اساس عادات رسانهای مخاطب و ماهیت محصول یا خدمت انجام میشود. برای مثال، اگر هدف کمپین فروش یک محصول دیجیتال به نسل جوان باشد، استفاده از تبلیغات اینستاگرام، تیکتاک یا یوتیوب اثربخشتر است. اما برای خدمات B2B، لینکدین و تبلیغات گوگل میتواند انتخاب بهتری باشد. تنوع کانالها در کمپین تبلیغاتی دیجیتال اهمیت زیادی دارد، اما باید متناسب با بودجهبندی تبلیغ و اهداف کلی انتخاب شوند. در بسیاری از موارد، ترکیب تبلیغات کلیکی، بازاریابی ایمیلی و تبلیغات نمایشی میتواند بهترین بازدهی را ایجاد کند. ۴. برنامه ریزی پیام و محتوای تبلیغاتی محتوای تبلیغاتی، قلب اجرای کمپین دیجیتال است. این محتوا باید با استراتژی برند هماهنگ باشد و پیام واحدی را در همه کانالها منتقل کند. استفاده از متنهای قانعکننده، تصاویر باکیفیت، ویدئوهای کوتاه و محتوای تعاملی میتواند تأثیر پیام را چند برابر کند. نکته مهم این است که در هدفگذاری تبلیغاتی باید محتوای هر کانال با ویژگیهای همان بستر تطبیق داده شود. مثلاً تبلیغ در گوگل نیازمند متن کوتاه و بهینه برای موتور جستجو است، در حالی که در اینستاگرام، تصویر و ویدئو نقش اصلی را دارند. ۵. بودجه بندی تبلیغ یکی از حساسترین مراحل طراحی کمپین، بودجهبندی تبلیغ است. در این بخش باید تصمیم بگیرید که چه میزان سرمایه به کل کمپین اختصاص داده شود و این سرمایه چگونه بین کانالهای تبلیغاتی تقسیم شود. دو رویکرد اصلی وجود دارد: بودجهبندی مبتنی بر اهداف (Objective-based Budgeting) که ابتدا هدفگذاری میشود و سپس بودجه متناسب

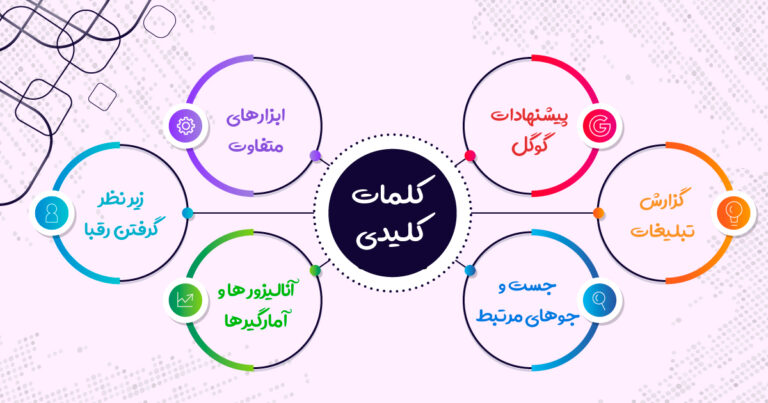

چگونه کلمات کلیدی مناسب را پیدا کنیم؟

پیدا کردن کلمات کلیدی مناسب یکی از مراحل اساسی در بهینهسازی موتور جستجو (SEO) است که میتواند به جذب ترافیک هدفمند و بهبود رتبه وبسایت کمک کند. 7 روش مؤثر برای شناسایی کلمات کلیدی با استفاده از این روشها و ابزارها، میتوانید کلمات کلیدی مناسب را شناسایی کرده و استراتژیهای سئو خود را بر اساس دادههای دقیق و تحلیلهای عمیق بهبود دهید. 1. تحقیق اولیه درباره کلمات کلیدی شناخت مخاطب هدف: ابتدا باید به خوبی مخاطبان هدف خود و نیازها و علایق آنها را بشناسید. این کمک میکند تا کلمات کلیدی مرتبط و متناسب با جستجوهای آنها را شناسایی کنید. تحلیل صنعت و رقبا: بررسی کلمات کلیدی که رقبا برای آنها رتبه دارند و تحلیل محتوای موفق آنها میتواند به شما در یافتن کلمات کلیدی مناسب کمک کند. 2. استفاده از ابزارهای تحقیق کلمات کلیدی Google Keyword Planner: ابزار رایگان گوگل برای شناسایی کلمات کلیدی مرتبط، حجم جستجو و سطح رقابت. این ابزار به شما پیشنهادات کلمات کلیدی و دادههای مرتبط ارائه میدهد. SEMrush و Ahrefs: ابزارهای پیشرفته که به شما امکان میدهند کلمات کلیدی را جستجو کرده و تحلیلهای عمیقتری درباره حجم جستجو، رقبا و کلمات کلیدی مشابه ارائه میدهند. Moz Keyword Explorer: ابزاری برای تحلیل کلمات کلیدی و شناسایی فرصتهای جدید. این ابزار اطلاعاتی درباره میزان رقابت و پتانسیل ترافیک ارائه میدهد. Ubersuggest: ابزار رایگان و پولی که به شما کمک میکند تا کلمات کلیدی جدید پیدا کنید و اطلاعاتی درباره حجم جستجو، رقابت و هزینه پیشنهادات ارائه میدهد. 3. استفاده از نتایج جستجوی گوگل پیشنهادات جستجو: هنگام جستجوی کلمات کلیدی در گوگل، نوار جستجو پیشنهادات و سوالات مرتبطی را نشان میدهد که میتواند به شما در شناسایی کلمات کلیدی جدید کمک کند. جستجوهای مرتبط: پایین نتایج جستجوی گوگل، بخشی به نام “جستجوهای مرتبط” وجود دارد که میتواند ایدههای جدید برای کلمات کلیدی فراهم کند. تحلیل SERP: بررسی نتایج صفحه جستجوی گوگل (SERP) برای کلمات کلیدی هدف، به شما کمک میکند تا ببینید چه نوع محتوایی در حال حاضر برای آن کلمات کلیدی رتبهبندی شده است. 4. ایجاد محتوای مبنای کلمات کلیدی استفاده از دادههای داخلی: بررسی کلمات کلیدی که در حال حاضر باعث جذب ترافیک به وبسایت شما میشوند و شناسایی کلمات کلیدی که ممکن است هنوز از آنها بهرهبرداری نکردید. پرسش و پاسخ: استفاده از پلتفرمهایی مانند Quora، Reddit و فرومهای مرتبط برای شناسایی سوالات و کلمات کلیدی که کاربران به دنبال پاسخ آنها هستند. 5. تحلیل رقبا ابزارهای تحلیل رقبا: ابزارهایی مانند SEMrush و Ahrefs به شما کمک میکنند تا کلمات کلیدی که رقبا در حال حاضر برای آنها رتبه دارند را شناسایی کنید و فرصتهای جدید را پیدا کنید. بررسی محتوای رقبا: تحلیل محتوای وبسایتهای رقیب و شناسایی کلمات کلیدی که آنها به خوبی از آنها استفاده کردهاند. 6. استفاده از روشهای خاص تحقیق درباره کلمات کلیدی طولانی (Long-Tail Keywords): کلمات کلیدی طولانی که بیشتر دقیق و کمتر رقابتی هستند میتوانند به جذب ترافیک هدفمند کمک کنند. این کلمات معمولاً جستجوهای خاصتری را هدف قرار میدهند و به کاربران کمک میکنند تا نیازهای خاص خود را پیدا کنند. تحلیل جستجوی محلی: برای کسبوکارهای محلی، استفاده از ابزارهایی مانند Google Trends و Google My Business برای شناسایی کلمات کلیدی مرتبط با مکان جغرافیایی و خدمات محلی. 7. تست و ارزیابی آزمون کلمات کلیدی: پیادهسازی کلمات کلیدی شناسایی شده و ارزیابی عملکرد آنها با استفاده از ابزارهای تحلیلی مانند Google Analytics و Google Search Console برای تعیین اثربخشی آنها. تنظیم و بهبود: بر اساس دادههای تحلیلی، تنظیم استراتژیهای کلمات کلیدی و بهینهسازی محتوا برای بهبود نتایج.

تفاوت بین سئوی داخلی و سئوی خارجی چیست؟

سئو داخلی چیست؟ درحالت کلی سئو داخلی عمل ها و فعالیت هایی میباشد که داخل سایت رخ میدهد و با توجه به استاندارد های گوگل و الگوریتم ها رعایت میشود. فعالیت های داخلی مانند بهینه سازی url ها، آپلود مقاله، بهینه سازی تصاویر، بهینه سازی محصولات، صفحات، دسته بندی ها، مقالات و… به عبارتی سئوی داخلی فعالیت هایی میباشد که داخل سایت شما قابل مشاهده است و مستقیم یا غیرمستقیم روی تجربه کاربری ورودی های سایت شما تاثیر میزارد. سئو خارجی چیست؟ احتمالا تا الان راجب مفهوم سئو خارجی حدس هایی زده اید و با توجه به نام این فعالیت به یک سری پاسخ ها در ذهن خود رسیدید. مفهوم سئوی خارجی اونقدراهم چیز پیچیده ای نیست و مفهوم کلی این فعالیت برمیگرده به خارج از سایت شما اما سوال اینجاست که بیرون از سایت چه کار هایی قراره به سایت ما کمک کند؟؟ درحالت کلی سئو خارجی همان جذب کاربر و یا امتیاز برای وب سایت هدف هستش، این جذب امتیاز و کاربر اغلب با تبلیغات در سایت های پرامتیاز انجام میشود که کمک بسیار زیادی به وب سایت هدف میکند. البته انتخاب یک تبلیغ مناسب با بهترین بازدهی اصلا کارراحتی نیست و نیاز به مهارت و تجربه در انتخاب یک کمپین مناسب را دارد. تفاوت سئوی داخلی و سئوی خارجی بر خلاف عقیده و انتظار اکثر مردم سئوی داخلی و خارجی دو ساید متضاد و مخالف نیستند و هردو شکل این فعالیت ها برای وب سایت لازم هستند. با توجه به آشنایی که با هردوی این فعالیت ها داشتیم، تفاوت سئو خارجی و سئو داخلی کاملا مشخص و واضح است اما نکته ای که لازمه بهش توجه کنیم نیاز وجود هردوی این فعالیت ها در یک وب سایت هستش. سئو داخلی (On-page SEO): به مجموعهای از فعالیتها و بهینهسازیهایی اشاره دارد که درون وبسایت انجام میشود و هدف آن بهبود تجربه کاربری و رعایت استانداردهای گوگل است. این فعالیتها شامل بهینهسازی URLها، تصاویر، محتوای صفحات، مقالات، و ساختار دستهبندیها است. این نوع سئو بهطور مستقیم بر نحوه دیده شدن وبسایت توسط موتورهای جستجو و تجربه کاربری تأثیر میگذارد. سئو خارجی (Off-page SEO): بر خلاف سئو داخلی، سئو خارجی به اقداماتی اطلاق میشود که خارج از وبسایت صورت میگیرد تا رتبهبندی و اعتبار وبسایت را افزایش دهد. این اقدامات شامل ایجاد لینکهای باکیفیت از وبسایتهای دیگر، تبلیغات در سایتهای معتبر و فعالیت در شبکههای اجتماعی است. هدف اصلی سئو خارجی جذب ترافیک و اعتبار بیشتر برای وبسایت از طریق منابع خارجی است. جمع بندی در حالی که سئو داخلی به بهبود ساختار و محتوای وبسایت برای جذب و نگهداری کاربران کمک میکند، سئو خارجی تمرکز بر افزایش اعتبار و دیده شدن وبسایت در فضای وب دارد. هر دو نوع سئو ضروری هستند و مکمل یکدیگر محسوب میشوند؛ سئو خارجی باعث جذب کاربران میشود و سئو داخلی کاربران جذبشده را به مشتریان دائمی تبدیل میکند. ترکیب این دو استراتژی برای موفقیت یک وبسایت ضروری است.

پایتون یا R – کدامیک برای دیتاساینس بهتر است؟

پایتون و R دو زبان برنامهنویسی محبوب در حوزه علم داده هستند که هر دو اکوسیستم غنی از کتابخانهها، ابزارها و فریمورکها را فراهم میکنند. این ویژگیها به دانشمندان داده کمک میکند تا بتوانند دادهها را بهطور کارآمد تحلیل و تجسم کنند، مدلهای یادگیری ماشین ایجاد کنند و به بینشهای ارزشمندی دست یابند. در این مقاله از وبلاگ کافهتدریس، به بررسی جداگانه پایتون و R میپردازیم، نقاط قوت و ضعف هرکدام را تحلیل میکنیم و در نهایت مشخص میکنیم که کدام زبان برای فعالیتهای علم داده مناسبتر است. پایتون در علم داده : چرا و چگونه؟ پایتون یکی از زبانهای برنامهنویسی چندمنظوره و محبوب است که بهدلیل سادگی، خوانایی و انعطافپذیری خود مورد توجه قرار گرفته است. این زبان بهخاطر ساختار قابل فهم و کاربرد گستردهاش، بهویژه در حوزه علم داده، انتخابی ایدهآل محسوب میشود. پایتون به مجموعهای غنی از کتابخانهها و چارچوبها مجهز است که آن را به ابزاری قدرتمند برای دستورزی دادهها، تحلیل، تجسم و یادگیری ماشین تبدیل کردهاند. در عرصه علم داده، پایتون نقش برجستهای دارد. کتابخانههایی مانند NumPy، Pandas، Matplotlib و Scikit-learn از جمله مهمترین ابزارهایی هستند که در این زمینه مورد استفاده قرار میگیرند. NumPy برای کار با آرایههای چندبعدی و عملیات ریاضیاتی پیچیده به کار میرود. Pandas ابزار قدرتمندی برای مدیریت و تجزیه و تحلیل دادههای ساختاریافته است. Matplotlib به تجسم دادهها کمک میکند و Scikit-learn نیز مجموعهای از الگوریتمهای یادگیری ماشین را در اختیار میگذارد. یکی از ویژگیهای بارز پایتون، یادگیری آسان آن برای مبتدیان است. ساختار ساده و قابل فهم کدهای پایتون، یادگیری اصول برنامهنویسی و علم داده را برای تازهکاران تسهیل میکند. علاوه بر این، قابلیتهای مقیاسپذیری و ادغام پایتون با سایر زبانها و سیستمها، آن را به گزینهای مناسب برای پروژههای بزرگ و پیچیده تبدیل کرده است. از دیگر مزایای پایتون میتوان به جامعه بزرگ و فعال آن اشاره کرد. این جامعه با ارائه منابع آموزشی، کتابخانههای جدید و بهروزرسانیهای منظم، به بهبود و گسترش پایتون کمک میکند. بنابراین، در هنگام مواجهه با مشکلات یا سوالات، شما همیشه میتوانید به جامعه پایتون تکیه کنید. پایتون نه تنها در زمینه علم داده بلکه در حوزههای دیگری مانند توسعه وب، اتوماسیون، هوش مصنوعی و بازیسازی نیز کاربرد دارد. این گستردگی کاربردها، پایتون را به زبانی همهکاره تبدیل کرده که میتواند نیازهای مختلف برنامهنویسان و تحلیلگران داده را برآورده کند. R برای علم داده : ابزار قدرتمند آماری و تجسمی زبان برنامهنویسی R بهعنوان یکی از اصلیترین ابزارهای مورد استفاده در تحلیل داده و تجسم آن، شناخته شده است. این زبان، بهطور ویژه برای انجام تحلیلهای آماری و تولید تصاویر گرافیکی پیچیده و باکیفیت طراحی شده است. R بهدلیل داشتن مجموعهای وسیع از پکیجهای آماری و گرافیکی، در میان آماردانان، محققان و تحلیلگران داده بسیار محبوب است. یکی از دلایل اصلی محبوبیت R، توانمندی بینظیر آن در تجزیهوتحلیل دادهها و مدلسازی آماری است. پکیجهایی مانند Tidyverse که شامل ابزارهایی همچون dplyr و ggplot2 است، امکانات فوقالعادهای را برای دستورزی دادهها و تجسم دادههای اکتشافی فراهم میکنند. بهعنوان مثال، dplyr به شما امکان میدهد تا دادهها را بهسرعت فیلتر، مرتبسازی و خلاصهسازی کنید، درحالیکه ggplot2 ابزاری قدرتمند برای ایجاد نمودارهای جذاب و معنادار است. یکی دیگر از ویژگیهای کلیدی R، محیط کنسولی تعاملی آن است که به کاربران امکان میدهد تا بهسرعت کدهای خود را اجرا و نتایج را مشاهده کنند. این ویژگی به ویژه برای نمونهسازی و آزمایشهای سریع بسیار مفید است، چراکه کاربران میتوانند بهسرعت تغییرات موردنظر خود را اعمال کرده و نتایج آن را بررسی کنند. این تعامل سریع و مستقیم با دادهها، فرآیند تحلیل را بهبود میبخشد و به کاربران کمک میکند تا بهراحتی الگوها و روندهای موجود در دادهها را شناسایی کنند. از دیگر مزایای R، پشتیبانی گسترده آن از انواع مختلف دادهها و فرمتها است. این زبان قادر است دادهها را از منابع مختلفی مانند فایلهای CSV، پایگاههای داده، و حتی وبسایتها وارد کرده و تجزیهوتحلیل کند. این انعطافپذیری در مدیریت دادهها، R را به ابزاری ایدهآل برای تحلیلگران داده تبدیل کرده است که نیاز به کار با مجموعههای داده متنوع دارند. علاوه بر این، جامعه بزرگ و فعال R، منبع غنی از دانش و پشتیبانی را فراهم میکند. انجمنهای آنلاین، مستندات جامع و دورههای آموزشی فراوان، به کاربران کمک میکنند تا بهسرعت با این زبان آشنا شوند و توانمندیهای خود را در استفاده از آن ارتقا دهند. تفاوت های میان Python و R پایتون: زبان برنامهنویسی همهکاره پایتون یک زبان برنامهنویسی همهکاره و بسیار انعطافپذیر است. از توسعه وب و نرمافزار تا یادگیری ماشین و تحلیل داده، پایتون توانایی انجام همه این کارها را با سرعت و کارایی بالا دارد. ساختار ساده و قابل فهم این زبان، آن را برای مبتدیان مناسب کرده و به همین دلیل است که در میان توسعهدهندگان نرمافزار و برنامهنویسان محبوبیت زیادی دارد. از سوی دیگر، R یک زبان تخصصی برای محاسبات آماری و تحلیل دادههای پیچیده است. این زبان بهویژه در محیطهای دانشگاهی و تحقیقاتی محبوب است و توسط آماردانان، دانشمندان و متخصصان تحقیق و توسعه (R&D) مورد استفاده قرار میگیرد. R برای انجام تحلیلهای آماری پیشرفته و تولید گرافهای با کیفیت بالا طراحی شده است و در این حوزهها بینظیر است. محبوبیت و کاربرد محبوبیت پایتون در میان برنامهنویسان و توسعهدهندگان بسیار بالاست و در ردهبندی زبانهای برنامهنویسی، معمولاً در صدر جدول قرار دارد. این در حالی است که R در جایگاه یازدهم قرار دارد. یکی از دلایل این تفاوت، سادگی یادگیری پایتون در مقایسه با R است. نحو پایتون بسیار سادهتر و قابل فهمتر است و این زبان دارای منابع آموزشی فراوانی است که یادگیری آن را آسانتر میکند. در مقابل، R زبانی پیچیدهتر و دشوارتر برای یادگیری است. این زبان به دلیل تمرکز بر تحلیلهای آماری پیچیده، دارای نحو و ساختار پیچیدهتری است که ممکن است برای مبتدیان چالشبرانگیز باشد. با این حال، کسانی که به تحلیل دادههای آماری پیشرفته علاقهمند هستند، ارزش یادگیری این زبان را به خوبی درک میکنند. دستمزد و بازار کار در زمینه دستمزد، جالب است که برنامهنویسان R بهطور متوسط دستمزد بیشتری نسبت به برنامهنویسان پایتون دریافت میکنند. میانگین دستمزد سالانه یک برنامهنویس پایتون حدود 100 هزار دلار است، در حالی که یک برنامهنویس R میتواند دستمزدی نزدیک به 118 هزار

سئو و گوگل ادوردز چه تفاوت هایی با یکدیگر دارند؟

در دنیای بازاریابی دیجیتال ، یکی از مهم ترین دغدغه های کسب و کارها افزایش دیده شدن در فضای آنلاین است. برای دستیابی به این هدف، روش های متنوعی وجود دارد، اما دو استراتژی اصلی که به طور گسترده مورد استفاده قرار می گیرند، سئو (SEO) و گوگل ادوردز (Google AdWords) هستند. در حالی که هر دو به دنبال افزایش بازدید از وب سایت ها و جذب مخاطبان هدف هستند، تفاوت های اساسی میان آن ها وجود دارد که درک این تفاوت ها برای کسب و کارها بسیار حیاتی است. سئو (SEO) به بهینه سازی وب سایت ها برای موتورهای جستجو اشاره دارد، به گونه ای که با استفاده از تکنیک های بهینه سازی داخلی و خارجی، وب سایت شما در نتایج جستجو به صورت ارگانیک رتبه بالاتری کسب کند. این روش نیازمند زمان و استراتژی دقیق است و هدف آن دستیابی به ترافیک پایدار و رایگان است. در مقابل ، گوگل ادوردز (Google AdWords) یا تبلیغات گوگل، یک روش پولی است که از طریق آن کسب و کار ها با پرداخت هزینه به گوگل، تبلیغات خود را در بالای نتایج جستجو نمایش می دهند. با این روش، کسب و کارها می توانند به سرعت در معرض دید مخاطبان هدف قرار گیرند، اما هزینه و نیاز به مدیریت دقیق کمپین ها از جمله چالش های آن است. گوگل ادز : چگونه با تبلیغات در گوگل ترافیک هدفمند جذب کنیم؟ گوگل ادز (Google Ads) یک پلتفرم تبلیغاتی قدرتمند است که توسط گوگل به کسب و کارها اجازه می دهد تا تبلیغات خود را در نتایج جستجوی گوگل و سایر وب سایت های مرتبط نمایش دهند. این سیستم به مدیران وب سایت ها امکان می دهد با استفاده از پرداخت به ازای کلیک (PPC)، ترافیک سریع و هدفمند به سایت خود جذب کنند. از آنجایی که این تبلیغات در صدر نتایج جستجو ظاهر می شوند، وب سایت های جدید می توانند سریع تر از طریق گوگل ادز توسط کاربران دیده شوند. گوگل ادز چگونه کار می کند؟ تبلیغات گوگل ادز بر اساس کلمات کلیدی انجام می شود. ابتدا، شما باید حساب Google Ads خود را ایجاد کنید و دامنه سایت خود را ثبت کنید. سپس، لیستی از کلمات کلیدی که کاربران ممکن است برای پیدا کردن محصولات یا خدمات شما جستجو کنند، انتخاب می کنید. بعد از تعیین کلمات کلیدی، مبلغی را به عنوان بودجه تبلیغاتی مشخص می کنید که در طول کمپین تبلیغاتی استفاده خواهد شد. هر بار که کاربری یکی از این کلمات کلیدی را جستجو کرده و روی تبلیغ شما کلیک کند، مبلغی از بودجه شما کسر می شود. یکی از ویژگی های مهم این سرویس این است که شما تنها وقتی هزینه پرداخت می کنید که تبلیغ شما برای کاربر قابل مشاهده باشد و کاربر روی آن کلیک کند. این روش به شما کمک می کند تا بهصورت هدفمند، ترافیک وارد سایت کنید و از هدررفت بودجه جلوگیری شود. با این حال، مدیریت بهینه تبلیغات و انتخاب صحیح کلمات کلیدی نیاز به تجربه و دانش دارد تا تبلیغات اثربخش و موفقیت آمیز باشد. مقایسه جامع سئو و گوگل ادز: کدام یک برای بیزینس شما مناسب تر است؟ سئو (SEO) و گوگل ادز (Google Ads) دو ابزار اصلی برای افزایش ترافیک وب سایت هستند، اما هرکدام رویکردها و مزایای متفاوتی دارند. اگرچه هر دو می توانند به بهبود جایگاه سایت در نتایج جستجو کمک کنند، تفاوت های عمده ای در نحوه عملکرد و نتایج آنها وجود دارد. تفاوت در زمان بندی و سرعت دستیابی به نتایج : اگر به دنبال کسب نتایج سریع هستید و می خواهید در کوتاه مدت به صدر نتایج گوگل برسید، گوگل ادز گزینه بهتری است. این تبلیغات به شما امکان می دهد ظرف چند روز و حتی چند ساعت ترافیک سایت خود را افزایش دهید. اما سئو یک فرآیند طولانی مدت است. بهینه سازی سایت برای موتورهای جستجو نیاز به زمان و تلاش مداوم دارد تا به رتبه های بالای گوگل دست یابید. با این حال، سئو در طولانی مدت می تواند نتایج پایدارتری به همراه داشته باشد. هزینه ها و بودجه : یکی از تفاوت های کلیدی میان سئو و گوگل ادز، نحوه پرداخت هزینه ها است. در گوگل ادز، شما به ازای هر کلیک (PPC) مبلغی را به گوگل پرداخت می کنید. اگرچه این روش می تواند به سرعت بازدیدکنندگان جدید را به سایت شما جذب کند، اما هزینه های آن می تواند بالا باشد، به خصوص اگر رقابت بر سر کلمات کلیدی هدف شما زیاد باشد. در مقابل، سئو هزینه بر نیست، اما به زمان و منابع انسانی نیاز دارد. شما باید محتوای باکیفیت تولید کنید، سایت خود را بهینه سازی کنید و به مرور زمان اعتماد و اعتبار بیشتری در گوگل کسب کنید. مدت زمان تاثیر گذاری : تفاوت دیگر در مدت زمان تاثیرگذاری نتایج است. گوگل ادز به شما این امکان را می دهد که فوراً ترافیک سایت خود را افزایش دهید، اما وقتی بودجه تبلیغاتی شما تمام شود، ترافیک هم کاهش می یابد. سئو، با اینکه زمان بر است، اما نتایج آن ماندگارتر است. وقتی سایت شما به رتبه های بالای گوگل برسد، ترافیک ارگانیک به صورت طبیعی و بدون نیاز به پرداخت مستقیم به گوگل ادامه می یابد. کلمات کلیدی و هدف گذاری : گوگل ادز به شما این امکان را میدهد که به صورت هم زمان تعداد زیادی از کلمات کلیدی را هدف قرار دهید. با تنظیمات گوگل ادز، شما می توانید از کمپین های مختلفی استفاده کنید تا به طور گسترده تری در معرض دید مخاطبان قرار بگیرید. از سوی دیگر، سئو نیاز به تمرکز بیشتری روی کلمات کلیدی دارد. شما باید برای هر صفحه و بخش از سایت خود، کلمات کلیدی مشخصی را انتخاب کرده و روی آنها کار کنید. رتبهبندی و ترافیک ارگانیک : سئو با هدف افزایش رتبه بندی ارگانیک وب سایت در نتایج جستجو کار می کند. رتبهبندی ارگانیک به معنای جذب ترافیک طبیعی از طریق بهینه سازی سایت و تولید محتوای ارزشمند است. در مقابل، گوگل ادز به شما امکان میدهد با پرداخت هزینه به نتایج بالای جستجو برسید. اما زمانی که تبلیغ شما غیرفعال شود، رتبه شما هم به همان سرعت از دست میرود. تاثیرات بلندمدت :

صفحه یتیم یا Orphan Page چیست؟

صفحه یتیم یا Orphan Page چیست؟ صفحه یتیم (Orphan Page) به صفحاتی از یک وب سایت گفته می شود که هیچ لینک داخلی از سایر صفحات سایت به آن ها ارجاع داده نشده است. به عبارتی، این صفحات در ساختار لینک سازی داخلی سایت قرار ندارند و کاربران و موتورهای جستجو نمی توانند به راحتی به آن ها دسترسی پیدا کنند. اگرچه این صفحات ممکن است محتوای مفیدی داشته باشند، اما به دلیل نداشتن لینک داخلی، به سختی دیده می شوند و اغلب توسط موتورهای جستجو نادیده گرفته می شوند. در دنیای سئو، صفحه یتیم می تواند به عملکرد ضعیف سایت منجر شود. زیرا یکی از عوامل مهم برای رتبه بندی صفحات، لینک های داخلی است که به موتورهای جستجو نشان می دهد کدام صفحات مهم تر هستند و باید ایندکس شوند. صفحات یتیم به دلیل نداشتن لینک ورودی، کمتر ایندکس می شوند و از جریان طبیعی ترافیک سایت نیز دور می مانند. مدیریت صحیح لینک سازی داخلی و یافتن و اصلاح صفحات یتیم می تواند به بهبود سئوی سایت و افزایش دسترسی کاربران به این صفحات کمک کند. در ادامه مقاله، به بررسی دقیقتر مفهوم صفحه یتیم، دلایل ایجاد آن و راهکارهای رفع این مشکل خواهیم پرداخت. دلایل به وجود آمدن صفحه یتیم چیست؟ اضافه کردن محتوا بدون برنامه ریزی لینک سازی داخلی یکی از رایج ترین دلایل به وجود آمدن صفحات یتیم، عدم برنامه ریزی صحیح برای لینک سازی داخلی هنگام انتشار محتوا است. ممکن است یک صفحه جدید به سایت اضافه شود، اما هیچ گونه لینکی از صفحات دیگر به آن ارجاع داده نشود. بهعبارتدیگر، صفحه جدید تولید شده اما فراموش شده که از سایر صفحات به آن لینک داده شود. این مشکل به ویژه در سایت هایی که حجم زیادی از محتوا منتشر می کنند، بیشتر دیده می شود. اگر محتوای جدید بدون توجه به لینک سازی داخلی منتشر شود، احتمال دارد که آن صفحه یتیم شود. تغییر ساختار سایت گاهی اوقات تغییرات در ساختار سایت باعث به وجود آمدن صفحات یتیم می شود. بهعنوان مثال، اگر بخش هایی از سایت بازسازی شوند یا دسته بندی ها تغییر کنند، ممکن است لینک هایی که قبلا به برخی صفحات اشاره داشتند حذف شوند یا تغییر کنند. اگر این لینک ها به درستی به روزرسانی نشوند، صفحه هایی که به آن ها لینک داده نمی شود، بهعنوان صفحات یتیم باقی می مانند. این مشکل معمولا در سایتهای بزرگ یا فروشگاههای آنلاین که ساختار پیچیدهتری دارند، رخ میدهد. حذف یا تغییر لینکهای داخلی گاهی اوقات لینکهای داخلی به دلیل ویرایش یا حذف محتوای صفحات، تغییر میکنند یا از بین میروند. برای مثال، اگر یک مقاله یا صفحهای که به چندین صفحه دیگر لینک داده شده بود حذف شود، ممکن است صفحاتی که به آن لینک شده بودند، یتیم شوند. بهطور مشابه، اگر لینکی به یک صفحه خاص تغییر داده شود یا بهطور کامل حذف شود، آن صفحه یتیم میشود. مهاجرت یا انتقال سایت در فرآیند مهاجرت سایت یا تغییر دامنه، برخی از لینکها ممکن است به اشتباه نادیده گرفته شوند. این مسئله بهویژه در مهاجرتهای بزرگمقیاس رخ میدهد. اگر در فرآیند انتقال، لینکهای داخلی به درستی بازسازی نشوند، برخی از صفحات بهطور کامل از ساختار سایت خارج میشوند و به صفحات یتیم تبدیل میشوند. بنابراین، در زمان مهاجرت سایت باید توجه زیادی به لینکهای داخلی داشت تا هیچ صفحهای یتیم نشود. اشتباهات فنی یا مشکلات CMS گاهی اوقات مشکلات فنی در سیستم مدیریت محتوا (CMS) یا قالب سایت ممکن است باعث شوند که برخی صفحات یتیم شوند. برای مثال، ممکن است سیستم به درستی نتواند لینکهای داخلی را مدیریت کند یا به دلیل باگها یا مشکلات فنی، برخی از لینکها از بین بروند. همچنین، در سایتهایی که بهصورت اتوماتیک محتوا تولید میکنند، ممکن است صفحات به دلیل نقصهای فنی یتیم شوند. صفحات فرود (Landing Pages) بدون لینک داخلی بسیاری از سایتها صفحات فرود ایجاد میکنند که بهطور مستقیم از طریق تبلیغات یا ایمیلها به آنها هدایت میشود. اگر این صفحات فرود (Landing Pages) در ساختار لینکسازی داخلی سایت قرار نگیرند، به صفحات یتیم تبدیل میشوند. این اتفاق بهویژه برای صفحاتی که برای کمپینهای موقت ایجاد میشوند، رخ میدهد. اگرچه این صفحات ممکن است بازدیدکنندگان خاص خود را داشته باشند، اما نبود لینک داخلی از سایر بخشهای سایت باعث میشود موتورهای جستجو نتوانند آنها را بهدرستی ایندکس کنند. صفحات یتیم پیج خود را چگونه پیدا کنیم؟ استفاده از Google Analytics (گوگل آنالیتیکس) گوگل آنالیتیکس یکی از بهترین ابزارهای رایگان برای پیدا کردن صفحات یتیم است. با استفاده از این ابزار، میتوانید رفتار کاربران در سایت خود را بهطور دقیق تجزیه و تحلیل کنید و ببینید که کدام صفحات ترافیک بسیار کمی دارند یا هیچ بازدیدی ندارند. صفحاتی که هیچ بازدید کننده ای ندارند، احتمالا یتیم هستند. برای پیدا کردن صفحات یتیم در گوگل آنالیتیکس وارد حساب کاربری گوگل آنالیتیکس شوید. به بخش “Behavior” بروید و سپس “Site Content” را انتخاب کنید. لیست صفحاتی که بازدیدهای کمی دارند یا اصلاً بازدیدی ندارند را بررسی کنید. این صفحات احتمالاً لینک داخلی ندارند و ممکن است یتیم باشند. استفاده از Google Search Console Google Search Console یکی دیگر از ابزارهای قدرتمند گوگل است که به شما کمک میکند وضعیت ایندکس شدن صفحات سایت خود را بررسی کنید. با استفاده از این ابزار میتوانید ببینید کدام صفحات سایت شما در نتایج جستجو ایندکس شدهاند و ترافیک دریافت میکنند. اگر صفحاتی در سایت شما ایندکس نشدهاند یا ترافیک کمی دارند، این احتمال وجود دارد که این صفحات یتیم باشند. برای بررسی صفحات در گوگل سرچ کنسول به بخش “Coverage” بروید. صفحاتی که خطای ایندکس دارند یا از ایندکس خارج شدهاند را بررسی کنید. این صفحات ممکن است یتیم باشند و به دلیل نداشتن لینک داخلی، گوگل قادر به ایندکس کردن آنها نباشد. استفاده از ابزارهای تخصصی سئو ابزارهای سئو مانند Screaming Frog، Ahrefs یا SEMrush نیز میتوانند بهطور حرفهای به شما کمک کنند تا صفحات یتیم سایت خود را پیدا کنید. این ابزارها با خزیدن (Crawl) در سایت شما، تمام لینکهای داخلی و خارجی را بررسی میکنند و صفحات یتیمی که هیچ لینکی به آنها ارجاع داده نشده است را شناسایی میکنند. در Screaming Frog، میتوانید وبسایت خود را خزش کنید و

محتوای همیشه سبز چیست؟

محتوای همیشه سبز یا Ever Green Content چیست؟ محتوای همیشه سبز، یکی از مهم ترین ابزارهای بازاریابی دیجیتال است که به کسب و کارها کمک می کند تا در طولانیمدت مخاطبان خود را جذب کنند و جایگاه خود را در بازار تثبیت کنند. برخلاف محتوای معمولی که در یک بازه زمانی کوتاه توجه مخاطبان را جلب میکند، محتوای همیشه سبز بدون از دست دادن ارزش خود در طول زمان همچنان مورد استفاده و توجه قرار میگیرد. به بیان ساده، این نوع محتوا به مسائل و موضوعاتی میپردازد که در هر زمانی کاربردی و مفید باقی میمانند. این نوع محتوا در قالبهای مختلفی مانند مقالات آموزشی ، نکات کاربردی ، راهنمایی های جامع و محتوای ویدئویی قابل ارائه است. هدف از ایجاد محتوای همیشه سبز، ارائه اطلاعاتی است که بدون توجه به تغییرات روزمره و تحولات سریع بازار، همچنان قابل استفاده باشد و برای خوانندگان جذابیت داشته باشد. برای بسیاری از کسب و کارها، ایجاد محتوای همیشه سبز به معنای سرمایهگذاری هوشمندانه در بازاریابی محتوا است. زیرا این محتوا نهتنها به افزایش ترافیک وب سایت کمک می کند، بلکه موجب ایجاد اعتماد و اعتبار در مخاطبان نیز می شود. در ادامه ، به بررسی ویژگیهای کلیدی این نوع محتوا و نحوه ی ایجاد آن پرداخته خواهد شد. تولید محتوای سبز چه مزایایی دارد؟ محتوای همیشه سبز یکی از مهمترین ابزارهای بازاریابی محتواست که به سایتها کمک میکند تا به شکل مداوم بازدیدکنندگان جدید جذب کنند و موقعیت خود را در نتایج موتورهای جستجو بهبود دهند. این نوع محتوا که همیشه مرتبط و تازه باقی میماند، به مرور زمان ارزش بیشتری پیدا میکند و نتایج مثبتی به همراه دارد. در ادامه به برخی از مهمترین مزایای تولید محتوای سبز میپردازیم: افزایش اعتبار سایت : یکی از بزرگترین مزایای تولید محتوای همیشه سبز، افزایش اعتبار سایت است. وقتی کاربران به وبسایت شما مراجعه میکنند و محتوایی را پیدا میکنند که پاسخ سوالات یا نیازهایشان را فراهم میکند، تمایل بیشتری به بازگشت و استفاده مجدد از سایت دارند. این اعتبار به مرور زمان افزایش مییابد و سایت شما را به عنوان یک منبع معتبر در زمینههای خاص معرفی میکند. هر چه اعتبار سایت بیشتر باشد، احتمال جذب مخاطبان بیشتر و همچنین افزایش اعتماد به برند شما نیز بالاتر خواهد بود. افزایش ترافیک ارگانیک و بهبود سئو : محتوای همیشه سبز به دلیل ماهیت طولانیمدت خود میتواند به بهبود سئو و افزایش ترافیک ارگانیک سایت کمک کند. موتورهای جستجو مانند گوگل محتوای کاربردی و با کیفیت را که پاسخگوی نیاز کاربران است، تشخیص میدهند و در نتایج بالاتر نمایش میدهند. از آنجا که محتوای سبز به مرور زمان قدیمی نمیشود، این محتوا میتواند برای سالها ترافیک ارگانیک به وبسایت شما هدایت کند. همچنین استفاده از کلمات کلیدی مرتبط با موضوع، باعث بهبود رتبه سایت در نتایج جستجو میشود. کاهش نیاز به تولید محتوای جدید مکرر : یکی دیگر از مزایای محتوای همیشه سبز این است که نیاز به تولید محتوای مکرر را کاهش میدهد. برخلاف محتوای خبری یا مرتبط با رویدادهای موقت، محتوای سبز همیشه مرتبط باقی میماند و شما میتوانید به جای تولید محتوای جدید، روی بهینهسازی و ارتقای محتوای قدیمی خود تمرکز کنید. این رویکرد به شما امکان میدهد زمان و منابع خود را به شکلی موثرتر مدیریت کنید. افزایش نرخ تبدیل : محتوای همیشه سبز میتواند نرخ تبدیل را افزایش دهد. از آنجایی که این نوع محتوا به نیازهای اساسی و دائمی کاربران پاسخ میدهد، احتمال اینکه کاربران به خریداران یا مشتریان دائمی تبدیل شوند بیشتر است. برای مثال، یک مقاله جامع راهنمای خرید که به بررسی ویژگیهای مهم محصول میپردازد، میتواند خوانندگان را به تصمیمگیری نهایی نزدیکتر کند و در نهایت فروش بیشتری ایجاد کند. بهبود تجربه کاربری : محتوای سبز به کاربران کمک میکند تا به سرعت به پاسخهای خود دست یابند. محتوای جامع و همیشگی، به عنوان یک منبع دائمی برای کاربران عمل میکند و نیازهای اطلاعاتی آنها را بدون نیاز به جستجوی مجدد برطرف میسازد. این مسئله نه تنها به رضایت کاربران کمک میکند، بلکه زمان ماندگاری آنها در سایت را افزایش میدهد. افزایش بک لینک ها : محتوای سبز به دلیل ارزش بالای خود به طور طبیعی میتواند بکلینکهای بیشتری جذب کند. وقتی سایر سایتها محتوای شما را به عنوان منبع معتبر در موضوعات خاص شناسایی کنند، تمایل بیشتری به لینک دادن به آن پیدا میکنند. این امر نه تنها اعتبار دامنه شما را افزایش میدهد، بلکه به بهبود رتبهبندی سئو کمک شایانی میکند. انعطاف پذیری در به روزرسانی : محتوای همیشه سبز قابلیت بهروزرسانی آسانی دارد. شما میتوانید با افزودن اطلاعات جدید یا اصلاح جزئیات، آن را به روز نگه دارید و از این طریق، همچنان مخاطبان جدید جذب کنید. این قابلیت به شما این امکان را میدهد که با تغییرات جدید در صنعت یا تکنولوژی، محتوای خود را تازه و بهروز نگه دارید. نحوه تولید یک Ever Green content چگونه است؟ تولید محتوای همیشه سبز نیاز به برنامهریزی و دقت دارد تا بتواند برای مدت طولانی مفید و جذاب باقی بماند. در ادامه مراحل گام به گام تولید این نوع محتوا را به شما معرفی میکنیم: انتخاب موضوع مناسب : اولین گام در تولید محتوای همیشه سبز، انتخاب موضوعی است که برای مدتها مرتبط و مفید باقی بماند. موضوعاتی مانند آموزشها، راهنماهای جامع، بررسیهای محصول، و مقالات تحلیلی درباره مسائل پایهای و غیر وابسته به زمان مناسب هستند. از انتخاب موضوعات مرتبط با رویدادهای خاص یا اخبار روزانه پرهیز کنید. به دنبال موضوعاتی باشید که همیشه برای مخاطبان شما کاربردی و جذاب باشند. تحقیق دقیق و کامل : پس از انتخاب موضوع، باید به صورت جامع و دقیق تحقیق کنید. منابع معتبر و بهروز را بررسی کرده و اطلاعاتی جمعآوری کنید که بتواند به مخاطبان شما ارزش ارائه دهد. از دادههای آماری، مقالات علمی و منابع معتبر استفاده کنید تا محتوای شما عمق و اعتبار بیشتری پیدا کند. محتوای همیشه سبز باید به گونهای باشد که حتی پس از سالها همچنان اطلاعات آن قابل استفاده باشد. نوشتن محتوای جامع و کامل : محتوای همیشه سبز باید کامل و جامع باشد. به تمام جوانب موضوع بپردازید و سوالات احتمالی مخاطبان را پوشش دهید. از نوشتن مطالب سطحی و کوتاه که جزئیات کافی ندارند خودداری کنید. هر

بالا بردن ورودی سایت در گوگل

بالا بردن ورودی سایت در گوگل بالا بردن ورودی سایت در گوگل، یکی از دغدغههای اصلی هر کسب و کاری است که به دنبال افزایش دیده شدن و جذب مخاطبان جدید میباشد. وقتی سایت شما در نتایج جستجوی گوگل جایگاه بالاتری داشته باشد، نه تنها تعداد بازدیدکنندگان افزایش مییابد، بلکه اعتبار و اعتماد به برند شما نیز بیشتر خواهد شد. برای بسیاری از کسبوکارها، دستیابی به این هدف به معنای موفقیت در استراتژیهای دیجیتال مارکتینگ و رشد در فضای رقابتی اینترنت است. اما چرا افزایش ورودی از گوگل اهمیت دارد؟ بیشتر کاربران اینترنت برای یافتن اطلاعات، محصولات یا خدمات موردنیاز خود از گوگل استفاده میکنند و معمولا فقط به لینکهای اولیه نتایج جستجو مراجعه میکنند. اگر سایت شما در صفحات اول و به ویژه در جایگاههای برتر گوگل قرار نگیرد، احتمال اینکه بازدیدکنندگان به سراغ سایت شما بیایند بسیار کم خواهد بود. از همین رو، بهینه سازی سایت برای موتورهای جستجو (SEO) و استفاده از تکنیک های مختلف برای افزایش ورودی اهمیت زیادی دارد. در این مقاله، به بررسی اصول و راهکارهای عملی برای بالا بردن ورودی سایت در گوگل می پردازیم. با دنبال کردن این راهکارها، میتوانید شانس بیشتری برای دیده شدن در نتایج جستجو و جذب مخاطبان بیشتر داشته باشید. دلایل اهمیت افزایش ورودی سایت چیست؟ افزایش ورودی سایت یکی از مهمترین اهداف هر کسبوکار آنلاین است. هر چه ورودی بیشتری به سایت خود جذب کنید، فرصتهای بیشتری برای رشد، افزایش فروش و ارتقای جایگاه برند خود خواهید داشت. در ادامه به چند دلیل کلیدی اهمیت این موضوع پرداخته میشود: افزایش درآمد و فروش : یکی از اصلی ترین دلایل اهمیت افزایش ورودی سایت، افزایش فرصتهای فروش است. هرچه بازدیدکنندگان بیشتری به سایت شما وارد شوند، احتمال بیشتری وجود دارد که تبدیل به مشتری شوند. برای مثال، یک فروشگاه آنلاین که تعداد ورودیهای بیشتری از گوگل دارد، شانس بیشتری برای فروش محصولات خود پیدا میکند. اگر بهینهسازی سایت درست انجام شود، حتی درصد کوچکی از بازدیدکنندگان میتوانند به مشتریان دائمی تبدیل شوند. افزایش اعتبار و برندینگ : سایتی که ورودی زیادی از طریق گوگل دریافت میکند، به مرور زمان اعتبار بیشتری پیدا میکند. وقتی کاربران مکرراً با نام سایت شما در نتایج جستجو مواجه شوند، برند شما به عنوان یک منبع معتبر و شناختهشده در ذهنشان ثبت میشود. این اعتبار به مرور زمان باعث تقویت جایگاه برند شما در بازار میشود. بهبود سئو و رتبه بندی گوگل : افزایش ورودی سایت بهطور مستقیم به بهبود سئو کمک میکند. وقتی کاربران زیادی به سایت شما وارد شوند و تعامل خوبی با محتوا داشته باشند (مانند مطالعه مطالب یا خرید محصولات)، گوگل این رفتار را بهعنوان یک سیگنال مثبت در نظر میگیرد و رتبه سایت شما در نتایج جستجو بهبود مییابد. این چرخه مثبت باعث افزایش مداوم ورودی سایت خواهد شد. دریافت بازخورد و بهبود محتوا : وقتی ورودی سایت افزایش یابد، شما از مخاطبان بیشتری بازخورد دریافت میکنید. این بازخوردها میتواند به بهبود محتوا، خدمات و محصولات شما کمک کند. به عنوان مثال، اگر یک بلاگ آموزشی تعداد زیادی بازدید داشته باشد، نویسندگان میتوانند متوجه شوند کدام موضوعات بیشتر مورد علاقه کاربران است و مطالب خود را در راستای نیاز آنها بهبود دهند. فرصت های همکاری و تبلیغات : سایتی که ترافیک بالایی دارد، جذابیت بیشتری برای سایر کسبوکارها و برندها به منظور همکاریهای تبلیغاتی ایجاد میکند. برای مثال، وبسایتی که ورودی زیادی از موتورهای جستجو دریافت میکند، میتواند با دیگر برندها قراردادهای تبلیغاتی پرسودتری منعقد کند. فرض کنید یک سایت فروشگاهی کوچک که محصولات دیجیتال میفروشد، به کمک استراتژیهای سئو موفق به افزایش ورودی از گوگل میشود. این سایت با افزایش ترافیک توانست در عرض چند ماه فروش خود را دو برابر کند. هرچه ورودی سایت بیشتر شد، سایت در رتبههای بالاتری قرار گرفت و بازدیدهای بیشتری جذب کرد، و این چرخه همچنان ادامه داشت. چگونه می توان ورودی سایت را افزایش داد؟ تبلیغات کلیکی (PPC) تبلیغات کلیکی یا PPC (Pay Per Click) یکی از رایجترین روشهای تبلیغات آنلاین است. در این روش شما به ازای هر کلیکی که کاربر روی تبلیغ شما انجام میدهد، مبلغی پرداخت میکنید. گوگل ادز (Google Ads) و فیسبوک ادز (Facebook Ads) از محبوبترین پلتفرمها برای تبلیغات کلیکی هستند. این روش به شما کمک میکند که خیلی سریع و در مدت زمان کوتاهی ترافیک به سایت خود جذب کنید، اما باید بودجه کافی داشته باشید. تبلیغات بنری تبلیغات بنری به شما امکان میدهد تبلیغات تصویری یا ویدئویی خود را در سایتهای دیگر نمایش دهید. این نوع تبلیغات معمولا در سایتهای بزرگ و پربازدید قرار میگیرند و میتوانند توجه کاربران را جلب کنند. هزینه این نوع تبلیغات معمولا بر اساس تعداد نمایش (Impressions) محاسبه میشود. با قرار دادن تبلیغ در سایتهای مرتبط با حوزه کاری خود، میتوانید ترافیک مرتبط و هدفمند جذب کنید. رپورتاژ آگهی رپورتاژ آگهی یک نوع تبلیغ محتوایی است که شما با پرداخت هزینه به سایتهای معتبر، محتوای خود را به صورت مقاله یا گزارش منتشر میکنید. این محتوا باید طبیعی و آموزشی باشد و در عین حال به محصولات یا خدمات شما اشاره کند. رپورتاژ آگهی میتواند علاوه بر جذب مخاطبان، به سئوی سایت شما نیز کمک کند، چرا که اغلب همراه با لینک به سایت شما منتشر میشود. تولید محتوای باکیفیت و همیشه سبز تولید محتوای باکیفیت و مفید یکی از بهترین راههای افزایش ورودی سایت است. کاربران به دنبال اطلاعات مفید، آموزشی یا سرگرمکننده هستند و اگر محتوای سایت شما این نیازها را برآورده کند، بازدیدکنندگان به سایت شما بازمیگردند. محتوای همیشه سبز، یعنی محتوایی که همیشه مفید و معتبر باقی بماند، میتواند در طولانیمدت ورودیهای مداوم برای سایت شما ایجاد کند. مقالات آموزشی، راهنماهای جامع و مطالب تحلیلی از نمونههای محتوای همیشه سبز هستند. استفاده از ایمیل مارکتینگ ایمیل مارکتینگ یکی از روشهای قدیمی ولی موثر برای جذب ورودی به سایت است. با ایجاد لیستی از ایمیل کاربران و ارسال خبرنامههای دورهای شامل محتواهای جذاب، اخبار و پیشنهادات ویژه، میتوانید کاربران را به بازدید از سایت خود تشویق کنید. این روش، اگر بهدرستی انجام شود، میتواند به یکی از پایدارترین منابع ترافیک سایت تبدیل شود. لینک سازی داخلی و خارجی لینکسازی (Link Building) یکی دیگر از تکنیکهای موثر در افزایش ورودی سایت است. لینکهای

دابلین کور (Dublin Core) چیست؟

دابلین کور (Dublin Core) چیست؟ دابلین کور (Dublin Core) یک استاندارد متادیتا است که در زمینه بهینه سازی سئو و دسترسی به محتواهای دیجیتال نقشی مهم ایفا می کند. این استاندارد ، مجموعه ای از عناصر ساده و قابل فهم برای توصیف منابع وب و دیجیتال، از جمله صفحات وب، اسناد، تصاویر و غیره ارائه می دهد. هدف اصلی دابلین کور، سازماندهی و بهبود دسترسی به اطلاعات است، به گونه ای که هم کاربران و هم موتورهای جستجو بتوانند به راحتی محتوای موردنظر خود را پیدا کنند. دابلین کور شامل ۱۵ عنصر کلیدی مانند عنوان ، نویسنده ، تاریخ انتشار و موضوع است که هر یک از آن ها به بهبود ساختار و نظم محتواهای دیجیتال کمک می کنند. با استفاده از این عناصر، موتورهای جستجو می توانند بهتر و دقیق تر محتوا را بررسی و رتبه بندی کنند، که این موضوع مستقیماً به بهبود سئو و افزایش دیده شدن سایت در نتایج جستجو منجر می شود. بهکارگیری دابلین کور در سئو ، به سایت ها کمک می کند تا اطلاعات خود را با نظم بیشتری در دسترس موتورهای جستجو قرار دهند، که در نتیجه باعث بهبود رتبهبندی و جذب ترافیک بیشتر میشود. در این مقاله، به بررسی جزئیات و کاربردهای این استاندارد در بهینهسازی سایت برای موتورهای جستجو خواهیم پرداخت. این استاندارد اولین بار در سال ۱۹۹۵ در کارگاهی در شهر دابلین، اوهایو شکل گرفت و به همین دلیل به نام “دابلین” شناخته میشود. هدف اصلی دابلین کور ایجاد چارچوبی ساده و قابلفهم برای توصیف منابع مختلف دیجیتال، از جمله اسناد، تصاویر، ویدئوها و دیگر محتواهای آنلاین است. انواع دابلین کور Dublin Core شامل دو نوع اصلی است : دابلین کور ساده و دابلین کور توسعه یافته. هر کدام از این انواع بسته به نیاز و پیچیدگی منابع اطلاعاتی، کاربرد خاص خود را دارند. دابلین کور ساده (Simple Dublin Core) دابلین کور ساده، نسخه اولیه و پایه این استاندارد است که شامل ۱۵ عنصر کلیدی میشود. این عناصر برای توصیف منابع اطلاعاتی به روشی ساده و استاندارد به کار میروند. هر کدام از این عناصر به صورت اختیاری هستند، اما بسته به نوع منبع میتوان از هر تعداد لازم استفاده کرد. این ۱۵ عنصر عبارتند از: عنوان (Title) : عنوان منبع اطلاعاتی. خالق (Creator) : فرد یا نهادی که منبع را ایجاد کرده است. موضوع (Subject) : موضوع یا کلمه کلیدی مرتبط با محتوای منبع. توضیحات (Description) : شرح کلی درباره منبع. ناشر (Publisher) : فرد یا سازمانی که منبع را منتشر کرده است. همکار (Contributor) : افرادی که در تولید منبع مشارکت داشتهاند. تاریخ (Date) : تاریخ ایجاد یا انتشار منبع. نوع (Type) : نوع محتوای منبع، مانند مقاله، ویدئو، یا تصویر. فرمت (Format) : فرمت فیزیکی یا دیجیتال منبع. شناسه (Identifier) : شناسهای که به منبع اطلاعاتی اختصاص داده شده است، مانند URL. منبع (Source) : منبع اولیهای که اطلاعات از آن گرفته شده است. زبان (Language) : زبان مورد استفاده در منبع. رابطه (Relation) : رابطه منبع با سایر منابع. پوشش (Coverage) : دامنه یا محدوده مکانی و زمانی که منبع پوشش میدهد. حقوق (Rights) : اطلاعات مربوط به حقوق و دسترسی به منبع. این نوع ساده از دابلین کور بیشتر برای توصیف منابع عمومی و ساده به کار میرود. هدف از استفاده از دابلین کور ساده، فراهم کردن توصیفی استاندارد و پایه برای منابع دیجیتال است، که هم کاربر و هم موتورهای جستجو بتوانند به راحتی از آن استفاده کنند. دابلین کور توسعه یافته (Qualified Dublin Core) دابلین کور توسعه یافته، نسخهای پیچیدهتر و کاملتر از این استاندارد است. در این نسخه، علاوه بر ۱۵ عنصر اولیه، از صفات اضافی و گسترشیافته برای تعریف دقیقتر منابع استفاده میشود. این نسخه به کاربران و توسعهدهندگان اجازه میدهد که اطلاعات دقیقتری را درباره منابع ارائه دهند و به صورت جامعتری محتوا را توصیف کنند. در دابلین کور توسعه یافته، هر عنصر میتواند با استفاده از صفات بیشتری توصیف شود. به عنوان مثال، عنصر “تاریخ” میتواند دقیقتر شده و به عنوان “تاریخ ایجاد” یا “تاریخ تغییر” مشخص شود. این نسخه همچنین اجازه میدهد که از ویژگیهای بیشتری برای توصیف منابع پیچیدهتر استفاده شود و امکان دستهبندی دقیقتری برای منابع اطلاعاتی فراهم می شود. دابلین کور چگونه روی سئو تاثیر می گذارد؟ بهبود قابلیت دسترسی محتوا اولین و شاید مهمترین تأثیر دابلین کور روی سئو، بهبود قابلیت دسترسی محتوا برای موتورهای جستجو است. موتورهای جستجو مانند گوگل، هنگام فهرستبندی صفحات وب به دنبال اطلاعات دقیق و سازمانیافته هستند تا بفهمند که محتوای یک صفحه درباره چیست. دابلین کور با ارائه اطلاعات ساختاریافتهای مانند عنوان، نویسنده، تاریخ انتشار و توضیحات، این فرآیند را سادهتر میکند. این کار باعث میشود که موتورهای جستجو بتوانند به طور دقیقتر و سریعتر صفحات شما را تحلیل کنند و به نمایش بهتری در نتایج جستجو دست یابید. بهبود رتبه بندی محتوا استفاده از دابلین کور میتواند به بهبود رتبهبندی صفحات وب در نتایج جستجو کمک کند. وقتی موتورهای جستجو اطلاعات کاملی از صفحه دریافت میکنند، میتوانند صفحات شما را بهعنوان منابع قابل اعتماد و کاملتر شناسایی کنند. این اعتبار باعث بهبود رتبهبندی سایت شما میشود. برای مثال، اگر از عنصر “عنوان” (Title) در دابلین کور بهدرستی استفاده کنید و یک عنوان دقیق و جذاب بنویسید، موتورهای جستجو این عنوان را برای نمایش در نتایج جستجو به کار خواهند گرفت. افزایش ترافیک ارگانیک هر چه صفحات وب شما بهینهتر باشند، احتمال افزایش ترافیک ارگانیک نیز بیشتر میشود. استفاده از دابلین کور باعث میشود که صفحات شما با دقت بیشتری در نتایج جستجو قرار بگیرند و کاربران بیشتری به سایت شما هدایت شوند. برای مثال، عنصر “توضیحات” (Description) در دابلین کور به شما کمک میکند تا یک توضیح مختصر و جامع درباره محتوای صفحه ارائه دهید که نه تنها برای موتورهای جستجو جذاب است، بلکه برای کاربران نیز ارزشمند خواهد بود. توضیحات واضح و مناسب کاربران را ترغیب میکند که بر روی لینک سایت شما کلیک کنند. افزایش نرخ کلیک (CTR) نرخ کلیک (CTR) یکی از عوامل مهم در سئو است که به موتورهای جستجو نشان میدهد چقدر کاربران به محتوای شما علاقهمند هستند. عناصر دابلین کور، بهویژه عنوان و توضیحات، تأثیر مستقیم بر نرخ کلیک دارند. اگر عنوان و توضیحات شما جذاب و مرتبط باشد،

هوش تجاری در فروش

هوش تجاری در فروش به معنای استفاده از داده ها و تحلیل های پیشرفته برای بهبود فرآیندهای فروش است. این نوع از هوش تجاری به کسب و کارها کمک می کند تا با تحلیل داده های موجود، الگوها و روندهای مشتریان را شناسایی کرده و تصمیم گیری های دقیقتری را در مورد استراتژیهای فروش اتخاذ کنند. به کمک هوش تجاری در فروش، شرکتها میتوانند به راحتی میزان فروش خود را پیش بینی کنند، مشتریان هدف را بهتر شناسایی کنند و استراتژی های مناسبی برای افزایش نرخ تبدیل و حفظ مشتریان به کار گیرند. این تکنولوژی با استفاده از ابزارهای تحلیل داده و داشبوردهای گزارش دهی، اطلاعات دقیقی را در اختیار مدیران فروش قرار میدهد تا بتوانند به سرعت واکنشهای مناسب نشان دهند و بهینه سازی عملکرد تیم فروش خود را تسهیل کنند. در واقع، هوش تجاری در فروش به عنوان یک ابزار قدرتمند، امکان تحلیل عملکرد فروش در گذشته، پیش بینی نیازهای آینده و اجرای راهبردهای بهتر را فراهم می کند که نهایتا به رشد و توسعه کسب و کار منجر می شود. مزایای هوش تجاری در بازاریابی با BI جمعیت شناسی مناسب را تعیین و هدف گذاری کنید یکی از اولین و مهم ترین مزایای هوش تجاری در بازاریابی، توانایی شناسایی و هدف گذاری دقیق بر اساس جمعیتشناسی است. با استفاده از ابزارهای هوش تجاری، بازاریابان میتوانند اطلاعات دقیقی درباره مشتریان فعلی و بالقوه خود به دست آورند. این اطلاعات میتواند شامل سن، جنسیت، محل زندگی، شغل و بسیاری دیگر از فاکتورهای جمعیتشناختی باشد. برای مثال، اگر یک شرکت آرایشی بخواهد محصول جدیدی را به بازار معرفی کند، میتواند با تحلیل دادههای جمعیتشناسی، مشخص کند که کدام گروه از مشتریان به احتمال زیاد به خرید این محصول علاقهمند خواهند بود. این اطلاعات به بازاریابان کمک میکند تا منابع خود را به طور کارآمدتری تخصیص دهند و بازده سرمایهگذاری خود را افزایش دهند. با BI سوال بازاریابی مناسب مطرح کنید هوش تجاری در بازاریابی به بازاریابان این امکان را میدهد که سوالات بازاریابی خود را به طور دقیقتری مطرح کنند. با تحلیل دادهها، بازاریابان میتوانند الگوهای رفتاری مشتریان را شناسایی کرده و بفهمند که چه عواملی باعث میشود مشتریان تصمیم به خرید بگیرند. برای مثال، اگر دادهها نشان دهند که مشتریان به تخفیفهای بزرگ بیشتر واکنش نشان میدهند، بازاریابان میتوانند کمپینهایی را طراحی کنند که بیشتر روی ارائه تخفیفهای جذاب تمرکز دارند. یا اگر دادهها نشان دهند که مشتریان پس از مشاهده ویدئوهای آموزشی درباره محصولات تصمیم به خرید میگیرند، بازاریابان میتوانند بر تولید محتوای ویدئویی تمرکز بیشتری کنند. این سوالات کمک میکنند که استراتژیهای بازاریابی به گونهای طراحی شوند که با نیازها و ترجیحات مشتریان همخوانی بیشتری داشته باشند. با BI گزارشات بازاریابی و تجاری را ساده کنید یکی دیگر از مزایای هوش تجاری در بازاریابی، سادهسازی فرآیند تهیه گزارشات بازاریابی و تجاری است. با استفاده از ابزارهای هوش تجاری، مانند Microsoft Power BI، تبلو و Qlik View ، بازاریابان می توانند داده های خود را به صورت بصری نمایش دهند و به راحتی تحلیل های مورد نیاز خود را انجام دهند. این ابزارها می توانند به بازاریابان کمک کنند تا نتایج کمپین های خود را به سرعت ارزیابی کرده و تصمیمات بهتری بگیرند. به عنوان مثال، بازاریابان می توانند گزارش هایی را تهیه کنند که نشاندهنده بازده سرمایه گذاری (ROI) کمپین های مختلف است و به آن ها کمک می کند تا بفهمند کدام استراتژی ها بیشترین بازدهی را دارند. این ویژگیها به بازاریابان اجازه میدهد تا به سرعت نقاط قوت و ضعف کمپینهای خود را شناسایی کرده و تغییرات لازم را اعمال کنند. به علاوه، ابزارهای هوش تجاری میتوانند به بازاریابان کمک کنند تا گزارشات خود را به صورت خودکار تهیه کرده و زمان بیشتری برای تمرکز بر روی تحلیل دادهها و بهبود استراتژیهای خود داشته باشند. اهمیت استفاده از هوش تجاری در فروش هوش تجاری ابزاری قدرتمند برای بهینهسازی فرآیندهای فروش است که از طریق تحلیل دقیق دادهها به سازمانها کمک میکند تا تصمیمات آگاهانهتری بگیرند. استفاده از هوش تجاری در فروش منجر به جمعآوری و تحلیل بینشهای عملی، درک عمیقتر از نیازهای سازمان، دستیابی به اهداف فروش و بازاریابی، پیشبینی رفتار مشتری، افزایش بهرهوری و تسریع در نرخ بازگشت سرمایه میشود. در ادامه، هر یک از این مزایا را بهصورت جداگانه بررسی میکنیم. جمع آوری بینش های عملی یکی از اصلیترین مزایای هوش تجاری در فروش، توانایی جمعآوری و تحلیل بینشهای عملی است. این فرآیند به سازمانها امکان میدهد تا دادههای متنوعی را از منابع مختلف جمعآوری کنند و سپس آنها را تحلیل کرده و به بینشهای قابل استفاده تبدیل کنند. برای مثال، از طریق ابزارهایی مانند Microsoft Power BI، میتوان دادههای مربوط به رفتار مشتریان در کانالهای مختلف فروش را تحلیل کرد و الگوهای مهم را شناسایی کرد. این بینشها میتوانند به تیمهای فروش کمک کنند تا نیازها و توقعات مشتریان را بهتر درک کرده و استراتژیهای فروش خود را بهبود بخشند. درک عمیق سازمانی استفاده از هوش تجاری در فروش به سازمانها کمک میکند تا به درک عمیقتری از عملکرد داخلی خود دست یابند. این درک عمیق به آنها اجازه میدهد تا ضعفها و نقاط قوت را شناسایی کرده و فرآیندهای خود را بهینهسازی کنند. برای مثال، با استفاده از SQL Server Analysis Services (SSAS)، میتوان دادههای فروش را مدلسازی کرده و تحلیلهای دقیقی انجام داد که نشاندهنده عملکرد تیمهای فروش و روندهای کلی بازار است. این تحلیلها به مدیران فروش کمک میکنند تا تصمیمات بهتری بگیرند و به بهبود فرآیندهای فروش کمک کنند. دستیابی به اهداف فروش و بازاریابی هوش تجاری به سازمانها امکان میدهد تا اهداف فروش و بازاریابی خود را بهصورت موثرتری دنبال کنند. با تحلیل دادههای مشتریان و بازار، سازمانها میتوانند اهداف دقیقتری تعیین کنند و استراتژیهای موثرتری برای دستیابی به این اهداف تدوین کنند. برای مثال، استفاده از ابزارهای هوش تجاری مانند Tableau میتواند به تیمهای فروش کمک کند تا گزارشهای دقیقی از عملکرد کمپینهای بازاریابی تهیه کنند و تصمیمات بهتری برای بهبود این کمپینها بگیرند. پیش بینی رفتار و روند خریدار با استفاده از هوش تجاری در فروش، سازمانها میتوانند رفتار و روند خریداران را پیشبینی کنند. این پیشبینیها به سازمانها کمک میکنند تا با تغییرات بازار همگام باشند و استراتژیهای فروش خود را بر

دلایل کندی وب سایت و ترفندهای رفع این مشکل

وقتی وب سایت شما به درستی کار نمی کند و کاربران با کندی سرعت رو به رو می شوند، تجربه کاربری آنها به شدت تحت تأثیر قرار می گیرد. در دنیای دیجیتال امروزی، بازدیدکنندگان وب سایت توقع دارند صفحات به سرعت بارگذاری شوند؛ اگر این اتفاق نیفتد، احتمالاً از سایت شما خارج می شوند و به سراغ رقبا می روند. دلایل کندی وب سایت می تواند بسیار متنوع باشد، از عواملی مثل سنگینی تصاویر و ویدئوها، تا بهینه نبودن کدها و یا مشکل در سرورها. علاوه بر این، افزایش ترافیک کاربران و استفاده نادرست از افزونههای متعدد نیز میتواند منجر به کاهش سرعت سایت شود. مدیریت صحیح منابع، بهینهسازی تصاویر و استفاده از شبکه توزیع محتوا (CDN) از جمله راهکارهایی است که میتوانند به بهبود سرعت وبسایت کمک کنند. همچنین بررسی و رفع مشکلات مربوط به سرور و دیتابیس نیز از موارد کلیدی در حل این مسئله است. در این مطلب، به بررسی دلایل اصلی کندی وب سایت پرداخته و ترفندهایی را برای رفع این مشکلات ارائه خواهیم کرد تا بتوانید تجربه کاربری بهتری برای بازدیدکنندگان خود فراهم کنید و از افت رتبه در موتورهای جستجو جلوگیری کنید. دلایل رایج برای کندی وب سایت کدنویسی غیرضروری و پیچیده : استفاده بیش از حد از کدهای اضافی میتواند سبب پیچیدگی و کاهش سرعت سایت شما شود. برای بهبود عملکرد وبسایت، باید کدها بهینه و به صورت ساختاریافته نوشته شوند. این باعث میشود که صفحات سریعتر بارگذاری شوند و کارایی سایت بهتر شود. به همین دلیل، هنگام همکاری با طراحان وب یا برنامهنویسان، باید به توانایی آنها در نوشتن کدهای بهینه و تمیز توجه ویژه داشته باشید. تصاویر با حجم بالا و زیاد : تصاویر با حجم بالا میتوانند بر سرعت بارگذاری سایت تأثیر منفی بگذارند. بهترین راهکار این است که تصاویر را بهینهسازی کرده و حجم آنها را کاهش دهید تا همزمان کیفیت مناسب حفظ شود. به عنوان مثال، میتوانید از ابزارهای آنلاین بهینهسازی تصویر مانند TinyPNG استفاده کنید تا بدون افت کیفیت، حجم تصاویر خود را کاهش دهید. استفاده از انیمیشن های فلش : هرچند فلش به شما امکان ایجاد انیمیشنهای زیبا را میدهد، اما امروزه بیشتر موتورهای جستجو مانند گوگل، محتوای فلش را ایندکس نمیکنند و همین موضوع تأثیر منفی بر سئوی سایت دارد. از طرفی، استفاده از فلش میتواند باعث سنگین شدن صفحات شود و سرعت بارگذاری را کاهش دهد. حجم زیاد ویدیوها : ویدیوها به طور طبیعی نیاز به پهنای باند بیشتری دارند. بنابراین، در صورتی که ویدیوهای زیادی در صفحات سایت قرار دهید، این موضوع میتواند زمان بارگذاری صفحات را بهطور چشمگیری افزایش دهد. برای جلوگیری از این مشکل، بهتر است از سرویسهای ویدیو مانند YouTube استفاده کنید و ویدیوها را در این سرویسها بارگذاری کرده و از طریق iframe به سایت خود اضافه کنید. نسخه های مختلف JQuery : در برخی موارد، برنامههای مختلفی که در CMS استفاده میکنید، نیاز به نسخههای متفاوتی از JQuery دارند که باعث بارگذاری چندباره این کتابخانه و افزایش زمان لود سایت میشود. برای جلوگیری از این مشکل، باید همه افزونهها و اسکریپتها را بررسی کرده و نسخههای مشابه یا بهینه را برای آنها انتخاب کنید. کدنویسی نامناسب جاوا اسکریپت : جاوااسکریپت یکی از اصلیترین دلایل کاهش سرعت سایت در صورتی است که به درستی به کار گرفته نشود. کدهای پیچیده و ناکارآمد میتوانند زمان بارگذاری سایت را بهشدت افزایش دهند. بنابراین، بهتر است از ابزارهای فشردهسازی و بهینهسازی جاوااسکریپت مانند UglifyJS برای بهبود کارایی سایت استفاده شود. استفاده بیش از حد از ابزارهای فانتزی : افزودن ابزارهای پر زرق و برق و عناصر تعاملی اضافی ممکن است ظاهر سایت را بهبود ببخشد، اما از سوی دیگر، باعث کندی آن خواهد شد. به جای تمرکز بر افکتهای زیبا، باید بر روی تجربه کاربری و بهینهسازی سرعت سایت متمرکز شوید. فرمت نادرست تصاویر : استفاده از فرمتهای نادرست مانند BMP میتواند سرعت سایت را کاهش دهد. باید از فرمتهای بهینه و متداول مانند JPEG برای تصاویر عادی و PNG برای آیکونها و تصاویر با پسزمینه شفاف استفاده کنید. درخواست های HTTP متعدد : هر فایل، تصویر، یا کد جداگانهای که در یک صفحه وب قرار میگیرد، نیازمند یک درخواست HTTP جداگانه است. بنابراین، برای بهینهسازی سرعت، باید تعداد این درخواستها را کاهش دهید. یکی از روشهای موثر، ادغام فایلهای CSS و JavaScript است. میزبانی مشترک (Shared Hosting) : در صورتی که از هاستینگ مشترک استفاده می کنید، منابع سرور بین سایت های مختلف تقسیم می شود و این مسئله میتواند سرعت سایت شما را کاهش دهد. اگر سایت شما ترافیک زیادی دارد، بهتر است از یک سرور اختصاصی یا هاستینگ ابری استفاده کنید. ترفندهای افزایش سرعت و عملکرد وب سایت انتخاب هاست قوی و مطمئن برای عملکرد بهتر یکی از عوامل کلیدی در سرعت وب سایت، استفاده از هاستینگ مناسب است. اگر وبسایت شما به صورت مشترک با وبسایتهای دیگر در یک سرور میزبانی شود، منابع سرور بین آنها تقسیم میشود که میتواند باعث کاهش سرعت شود. پیشنهاد میشود از هاستینگ ابری یا سرورهای اختصاصی استفاده کنید تا بتوانید از ترافیک سنگین جلوگیری کرده و سرعت بارگذاری صفحات را بهبود ببخشید. بهینه سازی هوشمندانه تصاویر و فایل های گرافیکی استفاده از تصاویر بزرگ و فایل های حجیم یکی از عوامل مهمی است که میتواند سرعت سایت شما را کاهش دهد. به جای بارگذاری تصاویر سنگین، میتوانید از فرمتهای فشردهشده و بهینهسازی شده استفاده کنید. ابزارهایی مانند TinyPNG یا ImageOptim به شما کمک میکنند که بدون کاهش کیفیت، حجم تصاویر را کم کنید. به عنوان مثال، اگر یک وبسایت فروشگاهی دارید، بهینهسازی عکسهای محصولات میتواند زمان بارگذاری صفحه را به شدت کاهش دهد. بهینه سازی کدها و اسکریپت ها برای بارگذاری سریع تر بارگذاری فایلهای جاوا اسکریپت و CSS به طور مستقیم بر زمان بارگذاری صفحات وب تأثیر میگذارد. اگر فایلها به صورت ناهماهنگ و بدون برنامهریزی بارگذاری شوند، وبسایت دچار کندی خواهد شد. یکی از بهترین راهها برای مقابله با این مشکل، استفاده از تکنیک Deferred Loading است. این روش به شما اجازه میدهد تا فایلهای اسکریپت که برای بارگذاری اولیه صفحه ضروری نیستند، در مرحله بعدی و پس از نمایش اولیه محتوا بارگذاری شوند. تکنیک Deferred Loading Deferred Loading (بارگذاری تأخیری) به این معناست که شما کدهایی را

جایگاه صفر گوگل چیست؟ چگونه به آن برسیم؟

در دنیای بهینه سازی موتورهای جستجو (SEO)، رسیدن به “جایگاه صفر گوگل” یا همان Google Featured Snippet یکی از اهداف مهم برای بسیاری از وب سایت هاست. جایگاه صفر، موقعیتی است که گوگل پیش از نمایش نتایج جستجوی عادی، پاسخ کوتاه و مشخصی به سوالات کاربران ارائه می دهد. این پاسخ ها معمولاً از یک وب سایت استخراج میشوند و به صورت برجسته در بالای صفحه نتایج جستجو نمایش داده میشوند. رسیدن به جایگاه صفر گوگل به وب سایت ها این امکان را می دهد که دیده شدن بیشتری داشته باشند و به سرعت توجه کاربران را به خود جلب کنند. این جایگاه میتواند تاثیر بسیار زیادی بر افزایش ترافیک وبسایت، بهبود رتبهبندی در نتایج جستجو و همچنین افزایش اعتبار وبسایت در زمینه تخصصی مورد نظر داشته باشد. برای دستیابی به این جایگاه، تولید محتوای باکیفیت و دقیق که به سوالات کاربران به صورت شفاف و سریع پاسخ دهد، اهمیت ویژهای دارد. محتوا باید بهینهسازی شده و به گونهای نوشته شود که گوگل آن را به عنوان بهترین پاسخ برای نمایش در جایگاه صفر تشخیص دهد. در ادامه، به تکنیکها و استراتژیهایی خواهیم پرداخت که به شما کمک میکند تا به جایگاه صفر گوگل برسید و از مزایای آن بهرهمند شوید. اهمیت کسب جایگاه صفر گوگل چیست؟ قرار گرفتن در موقعیت صفر گوگل یا Featured Snippet، برای وبسایتها مزایای زیادی دارد و این جایگاه یکی از اهداف اصلی در سئو است. در ادامه، برخی از مهمترین مزایا و دلایل اهمیت این جایگاه را بررسی میکنیم: افزایش قابل توجه نرخ کلیک (CTR) : یکی از مهمترین مزایای قرار گرفتن در جایگاه صفر، افزایش نرخ کلیک یا CTR است. جایگاه صفر در بالاترین نقطه از نتایج گوگل قرار میگیرد و با نمایش مختصری از پاسخ، کاربران را جذب میکند. بر خلاف تصور عمومی که فکر میکنند ارائه جواب در صفحه نتایج باعث کاهش کلیکها میشود، این جایگاه در عمل بیشترین کلیکها را به خود اختصاص میدهد. با افزایش کلیکها، سایت شما سرنخهای بیشتری جذب کرده و در نهایت فروش و درآمد بیشتری نیز کسب میکند. تصاحب قلمرو بیشتری از صفحه نتایج جستجو : قرار گرفتن در موقعیت صفر به معنای اشغال فضای بیشتری از نتایج جستجو است. شما نه تنها رقیبان را به پایین صفحه میرانید بلکه مخاطبان بیشتری را به سمت سایت خود هدایت میکنید. این باعث میشود که کاربران بیشتری از محتوای شما دیدن کنند و شانس تعاملات و تبدیلهای بیشتر ایجاد شود. بهبود رتبه کلی در نتایج جستجو (SERP) : اگر یک محتوای شما در جایگاه صفر قرار بگیرد، شانس بهبود رتبههای دیگر کلمات کلیدی نیز بالا میرود. الگوریتم گوگل این محتوا را بهعنوان منبع معتبر تشخیص میدهد و این موضوع میتواند به رتبهبندی بهتر برای سایر جستجوها منجر شود. نمایش در جستجوهای صوتی : با افزایش استفاده از دستیارهای صوتی مثل گوگل و الکسا، جایگاه صفر اهمیت بیشتری یافته است. موتورهای جستجو برای نمایش نتایج صوتی اغلب از اطلاعات موجود در این موقعیت استفاده میکنند. بنابراین، قرار گرفتن در این جایگاه نه تنها باعث جذب کاربران متنی بلکه باعث دیده شدن در جستجوهای صوتی هم میشود. افزایش اعتماد و اعتبار وبسایت : کاربران به نتایجی که گوگل در جایگاه صفر نمایش میدهد، اعتماد بیشتری دارند. این اعتماد به معنای بهبود اعتبار برند و کسبوکار شما است. اگر گوگل وبسایت شما را به عنوان مرجع معتبر نشان دهد، کاربران نیز به آن اعتماد بیشتری خواهند داشت. افزایش ترافیک ارگانیک : یکی دیگر از مزایای بزرگ قرار گرفتن در این موقعیت، افزایش قابلتوجه ترافیک ارگانیک است. وقتی محتوای شما مستقیماً در بالاترین نقطه صفحه نتایج قرار میگیرد، بیشتر کاربران روی آن کلیک میکنند و به سایت شما میآیند. این ترافیک ارگانیک میتواند منجر به رشد سریعتر وبسایت شود. حالا با توجه به همه این صحبتا ، گام های لازم برای رسیدن به جایگاه صفر چیست؟ گام های لازم برای جایگاه صفر چیست؟ برای رسیدن به جایگاه صفر گوگل، باید محتوای خود را به نحوی تنظیم کنید که نیاز کاربر را به سرعت و به صورت دقیق پاسخ دهد. این جایگاه به شما این امکان را میدهد که در بالاترین نقطه نتایج جستجو ظاهر شوید. در ادامه سه روش مؤثر برای دستیابی به این موقعیت توضیح داده شده است : ارائه پاسخ های کوتاه و دقیق : محتواهایی که در جایگاه صفر گوگل قرار میگیرند، معمولاً به سوالات کاربران با جملات کوتاه و دقیق پاسخ میدهند. این نوع پاسخها باید دقیقاً به سوال کاربر پرداخته و اطلاعات اضافی یا غیرضروری ارائه ندهند. به عنوان مثال، اگر کاربر به دنبال تعریف یک اصطلاح است، گوگل تمایل دارد تا از پاراگرافهای کوتاهی استفاده کند که تعریفی واضح و جامع ارائه دهند. فرض کنید کاربران عبارت “SEO چیست؟” را جستجو کنند، پاسخ شما میتواند به این شکل باشد: “SEO بهینهسازی سایت برای موتورهای جستجو است که با هدف افزایش بازدید و رتبهبندی وبسایتها انجام میشود.” نکته: محدود کردن پاسخ به حدود 40 تا 60 کلمه کلیدی است، زیرا این مقدار ایدهآل برای جایگاه صفر گوگل است. استفاده از لیست های شماره گذاری شده یا بولت ها : لیستهای مرحله به مرحله یکی از مؤثرترین ابزارها برای قرارگیری در جایگاه صفر هستند. اگر محتوای شما شامل مراحل انجام یک کار یا فهرستی از نکات مهم باشد، بهتر است از لیستهای شمارهگذاریشده یا بولتی استفاده کنید. برای مثال، اگر کاربر عبارت “مراحل بهینهسازی وبسایت برای سئو” را جستجو کند، لیستی شامل مراحل زیر میتواند در موقعیت صفر ظاهر شود: انتخاب کلمات کلیدی مرتبط بهینه سازی عناوین و متا توضیحات بهبود سرعت بارگذاری سایت ایجاد محتوای باکیفیت کسب بک لینکهای با ارزش این لیست به طور دقیق و مرتب به سوالات پاسخ میدهد و گوگل نیز معمولاً چنین محتواهایی را به عنوان پاسخهای سریع نمایش میدهد. بهینه سازی محتوا با توجه به اصول سئو : همانطور که تولید محتوای با کیفیت اهمیت دارد، بهینهسازی فنی محتوا نیز نقش کلیدی دارد. بهینهسازی سئو شامل استفاده از تگهای هدینگ (H1، H2 و H3) است که ساختار مناسبی به محتوا میدهد. همچنین تصاویر باید با تگ Alt همراه باشند و از لینکسازی داخلی استفاده کنید تا محتوای شما به صفحات دیگر سایت لینک داشته باشد. نکته: URLهای کوتاه و مفهومی به گوگل کمک میکند محتوای شما را