در این مقاله، به بررسی تفاوت های بین web scraping و web crawling و چگونگی ارتباط این دو فرآیند با یکدیگر خواهیم پرداخت. همچنین به معرفی برخی کاربردهای این دو تکنیک و ابزارهایی که میتوانید برای هر کدام استفاده کنید، میپردازیم. هدف ما این است که به شما کمک کنیم تا درک بهتری از این دو مفهوم کلیدی در دنیای داده های وب داشته باشید و بدانید چگونه میتوانند به بهبود پروژه های شما کمک کنند.

حالا بریم سراغ اصل مطلب :

وب اسکرپینگ چیست؟

وب اسکرپینگ فرآیندی است که در آن دادهها از یک وبسایت به صورت خودکار توسط رباتهای برنامهریزیشده استخراج میشوند. پس از استخراج، این دادهها جمعآوری و در قالبهای مختلف مانند فایلهای Excel، پایگاههای داده یا حتی فرمتهای سفارشی ذخیره میشوند. این فرآیند به کاربران اجازه میدهد تا به راحتی اطلاعات مورد نیاز خود را از وبسایتها استخراج کرده و برای تحلیل، استفادههای شخصی یا تجاری از آنها بهره ببرند.

چگونگی کارکرد وب اسکرپینگ :

وب اسکرپینگ همیشه کار سادهای نیست. توانایی استخراج دادهها از یک وبسایت به شدت به ساختار و محتوای آن سایت بستگی دارد. اگر سایت مورد نظر شامل عناصر پیچیده مانند تصاویر، صفحات با جاوا اسکریپت رندر شده، یا محتوای پویا باشد، فرآیند استخراج دادهها پیچیدهتر میشود. علاوه بر این، وبسایتها اغلب بهروزرسانی میشوند و این تغییرات میتواند باعث شود که کدهای اسکرپر شما از کار بیفتد و نیاز به تنظیم مجدد داشته باشند.

ربات های خزشگر وب :

رباتهای خزشگر که به آنها اسکرپر (Scraper) نیز گفته میشود، برای انجام فرآیند وب اسکرپینگ طراحی شدهاند. این رباتها بهطور خودکار لیستی از URLها را دریافت کرده، کدهای HTML آنها را بارگیری و اطلاعات مورد نیاز را استخراج میکنند. رباتهای پیشرفتهتر میتوانند نه تنها HTML، بلکه کل وبسایت شامل CSS و جاوا اسکریپت را نیز پردازش کرده و دادههای آن را استخراج کنند.

نمونهای از ساخت وب اسکرپر :

برای درک بهتر چگونگی عملکرد وب اسکرپینگ، یک نمونه کد ساده به زبان Python با استفاده از کتابخانهی BeautifulSoup و Requests ارائه میدهیم. این کتابخانهها ابزارهای قدرتمندی برای استخراج دادهها از صفحات وب هستند.

import requests

from bs4 import BeautifulSoup

# URL صفحهای که میخواهیم دادهها را از آن استخراج کنیم

url = ‘https://example.com’

# ارسال درخواست به URL و دریافت محتوا

response = requests.get(url)

# بررسی وضعیت پاسخ

if response.status_code == 200:

# پردازش HTML با استفاده از BeautifulSoup

soup = BeautifulSoup(response.text, ‘html.parser’)

# یافتن تمام تگهای h2 در صفحه

titles = soup.find_all(‘h2’)

# نمایش عنوانها

for title in titles:

print(title.get_text())

else:

print(f”خطا در دریافت صفحه. وضعیت: {response.status_code}”)

توضیحات کد :

- کتابخانهها : ابتدا کتابخانههای مورد نیاز را وارد میکنیم.

requestsبرای ارسال درخواست به وبسایت و دریافت محتوای صفحه استفاده میشود، وBeautifulSoupبرای تجزیه و تحلیل HTML. - URL : در این مثال،

urlصفحهای است که میخواهیم دادهها را از آن استخراج کنیم. - درخواست و پاسخ : با استفاده از

requests.get(url)یک درخواست به وبسایت ارسال میکنیم و پاسخ (response) را دریافت میکنیم. - پردازش HTML : اگر درخواست موفقیت آمیز بود (وضعیت 200)، محتوای HTML صفحه با استفاده از

BeautifulSoupتجزیه میشود. - استخراج دادهها : در اینجا، تمام تگهای

h2صفحه را پیدا کرده و متن داخل آن ها را چاپ میکنیم.

استفاده از وب اسکرپینگ با چالش های متعددی همراه است. برخی از سایت ها به دلیل قوانین کپی رایت یا حریم خصوصی ، اجازه اسکرپینگ را نمیدهند و ممکن است با استفاده از CAPTCHAs یا محدودیت های نرخ درخواست (Rate Limiting) از آن جلوگیری کنند. همچنین، مهم است که به قوانین و سیاست های استفاده از داده ها (Terms of Service) وبسایت ها احترام بگذارید و از اسکرپینگ فقط در موارد قانونی و اخلاقی استفاده کنید.

وب کراولینگ چیست؟

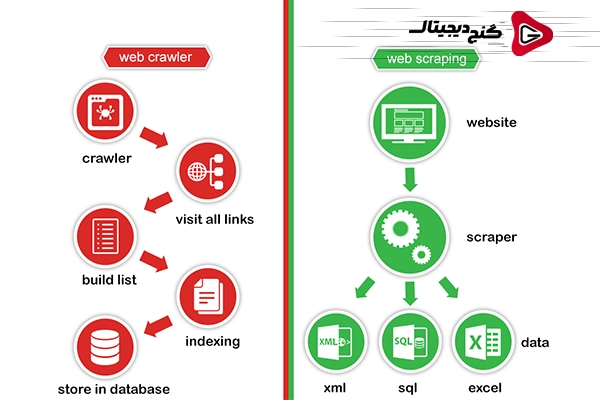

وب کراولینگ فرآیندی است که طی آن اطلاعات از سراسر وب به صورت خودکار جمعآوری میشوند. برخلاف وب اسکرپینگ که به استخراج دادهها از یک صفحه خاص محدود میشود، وب کراولینگ بهطور خودکار بین صفحات مختلف وبسایتها حرکت میکند و از طریق دنبال کردن لینکها به جمعآوری اطلاعات میپردازد. این دقیقاً همان روشی است که موتورهای جستجو مانند گوگل برای ایندکس کردن وبسایتها و مرتبسازی اطلاعات استفاده میکنند. آنها از رباتهای خزنده وب، یا همان “وب کراولرها”، برای پیمایش لینکها و سازماندهی دادهها بهره میبرند.

چگونگی کارکرد وب کراولینگ :

وب کراولرها برای شروع کار به یک نقطه ورود نیاز دارند که معمولاً یک لینک به صفحه اصلی یک وبسایت است. پس از ورود به این صفحه، کراولر شروع به دنبال کردن لینکهای داخلی آن صفحه میکند و بهطور متوالی به صفحات دیگر سایت میرود. این فرآیند ادامه مییابد تا کراولر تمام لینکهای موجود را پیمایش و اطلاعات مرتبط را جمعآوری کند. در این روش، میتوان بهطور جامع دادهها را از سایتهای مختلف استخراج کرد و اطلاعات را به صورت ساختاریافته ذخیره کرد.

نمونهای از ساخت وب کراولر :

import requests

from bs4 import BeautifulSoup

from queue import Queue

def crawl(url, max_depth):

visited = set()

q = Queue()

q.put((url, 0))

while not q.empty():

current_url, depth = q.get()

if current_url in visited or depth > max_depth:

continue

visited.add(current_url)

print(f”Crawling: {current_url} (Depth: {depth})”)

try:

response = requests.get(current_url)

soup = BeautifulSoup(response.text, ‘html.parser’)

for link in soup.find_all(‘a’, href=True):

next_url = link[‘href’]

if not next_url.startswith(‘http’):

next_url = url + next_url

q.put((next_url, depth + 1))

except requests.exceptions.RequestException as e:

print(f”Failed to fetch {current_url}: {e}”)

if __name__ == “__main__”:

start_url = ‘https://example.com’

crawl(start_url, max_depth=2)

- کتابخانه ها :

requestsبرای ارسال درخواست به وبسایتها و دریافت پاسخها استفاده میشود.BeautifulSoupبرای تجزیه و تحلیل HTML صفحات به کار میرود.queueنیز برای مدیریت صف لینکهای در حال بررسی استفاده میشود. - تابع

crawl: این تابع یک URL و عمق خزیدن (depth) را به عنوان ورودی دریافت میکند و شروع به خزیدن در صفحات وب میکند. - مدیریت لینک ها : لینکهای موجود در هر صفحه شناسایی میشوند و به صف لینکها اضافه میگردند تا در ادامه خزیده شوند. عمق خزیدن نیز کنترل میشود تا از پیمایش بیش از حد جلوگیری شود.

- اجرای کراولر : با اجرای اسکریپت، فرایند خزیدن از

start_urlآغاز میشود و تا رسیدن به عمق مشخصشده ادامه پیدا میکند.

ولی حالا تفاوت بین Web Scrapping و Web Crawling کجاست؟

تفاوت بین وب کراولینگ و وب اسکرپینگ اغلب مورد توجه قرار نمیگیرد و این دو تکنیک به اشتباه به جای یکدیگر استفاده میشوند. اما این دو روش در واقع تفاوتهای مهم و کاربردی دارند که باید به آنها توجه شود.

تفاوت اصلی :

وب اسکرپینگ (Web Scraping) به فرآیند استخراج دادهها از یک یا چند وبسایت خاص اشاره دارد. در این روش، دادههای مورد نیاز از صفحات وب جمعآوری و در قالبهای مختلف مانند فایلهای Excel یا پایگاههای داده ذخیره میشوند.

وب کراولینگ (Web Crawling) اما به پیمایش خودکار بین لینکهای مختلف یک یا چند وبسایت به منظور کشف و فهرستبندی صفحات جدید گفته میشود. این تکنیک بیشتر برای پیمایش در وب و یافتن صفحات جدید برای ایندکس کردن توسط موتورهای جستجو مورد استفاده قرار میگیرد.

یک تفاوت بزرگ دیگر میان وب کراولینگ و وب اسکرپینگ این است که در وب اسکرپینگ، تمرکز اصلی بر روی دادههاست. در این روش، شما معمولاً میدانید که از چه وبسایتهایی قصد استخراج داده را دارید؛ حتی اگر URL دقیق صفحات را ندانید، دامنه وبسایت را میشناسید. اما در وب کراولینگ، معمولاً نه URL و نه دامنه وبسایتها را از پیش نمیدانید. هدف اصلی کراولینگ، پیمایش لینکها به منظور کشف URLهای جدید است که سپس میتوانند برای اهداف مختلف، از جمله ایندکس شدن در موتورهای جستجو یا استخراج داده، مورد استفاده قرار گیرند.

ترکیب وب کراولینگ و وب اسکرپینگ :

در بسیاری از پروژههای استخراج داده از وب، این دو تکنیک اغلب با هم ترکیب میشوند. ابتدا با استفاده از یک وب کراولر (Crawler) لینکهای مختلف را پیمایش کرده و صفحات جدید را کشف میکنید. سپس با استفاده از یک وب اسکرپر (Scraper) دادههای مورد نیاز را از این صفحات استخراج میکنید. وب کراولرها تنها مسئول پیمایش لینکها هستند و هیچ دادهای را از صفحات استخراج نمیکنند؛ این وظیفه تنها بر عهده وب اسکرپرهاست.

مقایسه خلاصه :

| Web Scraping | Web Crawling |

|---|---|

| فقط دادهها را از صفحات استخراج میکند | وظیفه پیمایش لینکها و کشف صفحات جدید را دارد |

| بر روی استخراج داده از صفحات خاص تمرکز دارد | URLها و صفحات جدید را بدون استخراج داده ذخیره میکند |

| معمولاً دامنه وبسایتها مشخص است | هدف اصلی پیدا کردن URLها و صفحات جدید است |

سخن پایانی

در نهایت، وب اسکرپینگ و وب کراولینگ دو تکنیک قدرتمند برای جمعآوری دادهها از وب هستند که هر کدام کاربردهای خاص خود را دارند. وب اسکرپینگ به استخراج دقیق دادههای مورد نیاز از صفحات مشخص میپردازد، در حالی که وب کراولینگ با پیمایش و کشف صفحات جدید به جمعآوری اطلاعات گستردهتر کمک میکند. با ترکیب این دو روش، میتوان به دادههای ارزشمند و جامعی دست یافت که برای تحلیل، تحقیق و توسعه کسبوکار بسیار مفید هستند. با درک تفاوتها و کاربردهای هر کدام، میتوانید بهینهترین راهکار را برای نیازهای خود انتخاب کنید.